阿里云重磅开源qwen2.5-1m大模型,支持百万tokens上下文!该模型提供7b和14b两种尺寸,在处理长文本任务中显著超越gpt-4o-mini。阿里云还同步开源了推理框架,大幅提升了长文本处理速度。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

百万Tokens上下文能力意味着模型能够处理相当于10部长篇小说、150小时演讲稿或3万行代码的文本量。继两个月前Qwen2.5-Turbo升级百万Tokens上下文后,此次开源进一步降低了开发者和企业的使用门槛。 开发者可以利用Qwen2.5-1M进行长篇小说分析、学术论文解析,甚至探索仓库级代码的分析和优化。

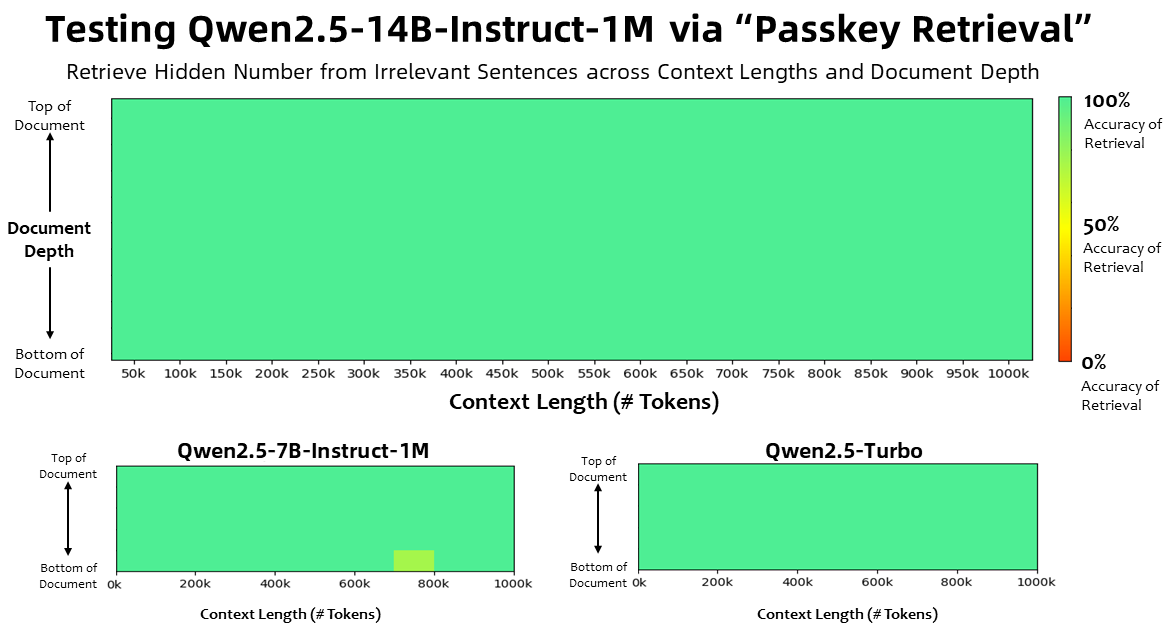

在“大海捞针”等长文本理解基准测试中,Qwen2.5-1M展现出卓越性能,甚至在部分测试中超越了GPT-4o-mini。 阿里云团队通过创新性的长度外推技术和Dual Chunk Attention机制,高效地将模型上下文长度扩展至百万级别,同时有效控制了成本。

为了优化推理速度,阿里云团队在vLLM推理引擎基础上,引入了基于Minference的稀疏注意力机制等多项改进,将处理百万级别长文本输入的预填充速度提升了3.2倍到6.7倍。

Qwen2.5-1M模型及其推理框架已在魔搭社区ModelScope、HuggingFace和GitHub上开源,方便开发者下载和使用。 开发者和企业也可以通过阿里云百炼平台调用Qwen2.5-Turbo模型API,或通过Qwen Chat平台体验模型性能。

相关链接:

演示Demo:https://www.php.cn/link/a49ffb16c3666d2f693bc7b5fdca969d

Modelscope:https://www.php.cn/link/d9e7aeae02fade22d8a268303051be75

Huggingface:https://www.php.cn/link/1d4bf338b9f623355c3dfc9f20aa2b53

开源框架地址:https://www.php.cn/link/b1d4b6452378d64ccbfe7f20fca7843c

Qwen Chat体验:https://www.php.cn/link/4c2d760f60a6ea70b0a10ef9ff2351f5

以上就是阿里云通义开源长文本模型及推理框架,百万Tokens处理速度提升近7倍的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号