腾讯ai lab联合苏州大学、上海交通大学团队的研究揭示了长推理模型的“思考不足”现象,并提出了一种改进方法。这项研究发表于arxiv,通讯作者为腾讯专家研究员涂兆鹏。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

研究发现,类似OpenAI o1等长推理模型,虽然展现出强大的深度思考能力,但在解决复杂问题时,往往会频繁切换思路,无法深入思考某个方向,导致最终答案错误。 研究团队将这种现象称为“思考不足”(Underthinking),并将其比喻为模型的“注意力缺陷多动障碍”。

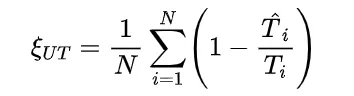

研究团队通过分析不同难度级别的数学问题,发现模型在难题上的错误答案往往伴随着更多的思路切换和更长的 token 数量,但准确率并未提升。 他们进一步提出了一种“思考不足”评分机制,定量评估模型在错误回答中推理效率的低下程度。

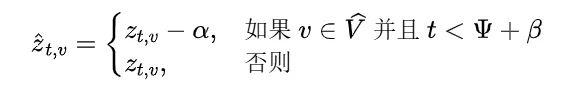

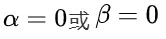

为解决这个问题,研究团队提出了一种名为“思路转换惩罚”(Thought Switching Penalty,TIP)的解码策略,通过惩罚思路切换行为来鼓励模型更深入地思考。实验结果表明,TIP策略能够有效提升模型的准确率并降低“思考不足”现象。 这项研究为改进长推理模型提供了新的思路和方法。

以上就是从想太多到想不透?DeepSeek-R1等长推理模型也存在「思考不足」问题的详细内容,更多请关注php中文网其它相关文章!

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号