发布《把ai带回家:deepseek-r1本地部署指南!再也不怕宕机了!!》后,许多读者通过私信询问关于deepseek-r1本地部署的电脑配置要求。今天,我们将详细探讨deepseek-r1各个版本的配置需求及其适用场景。

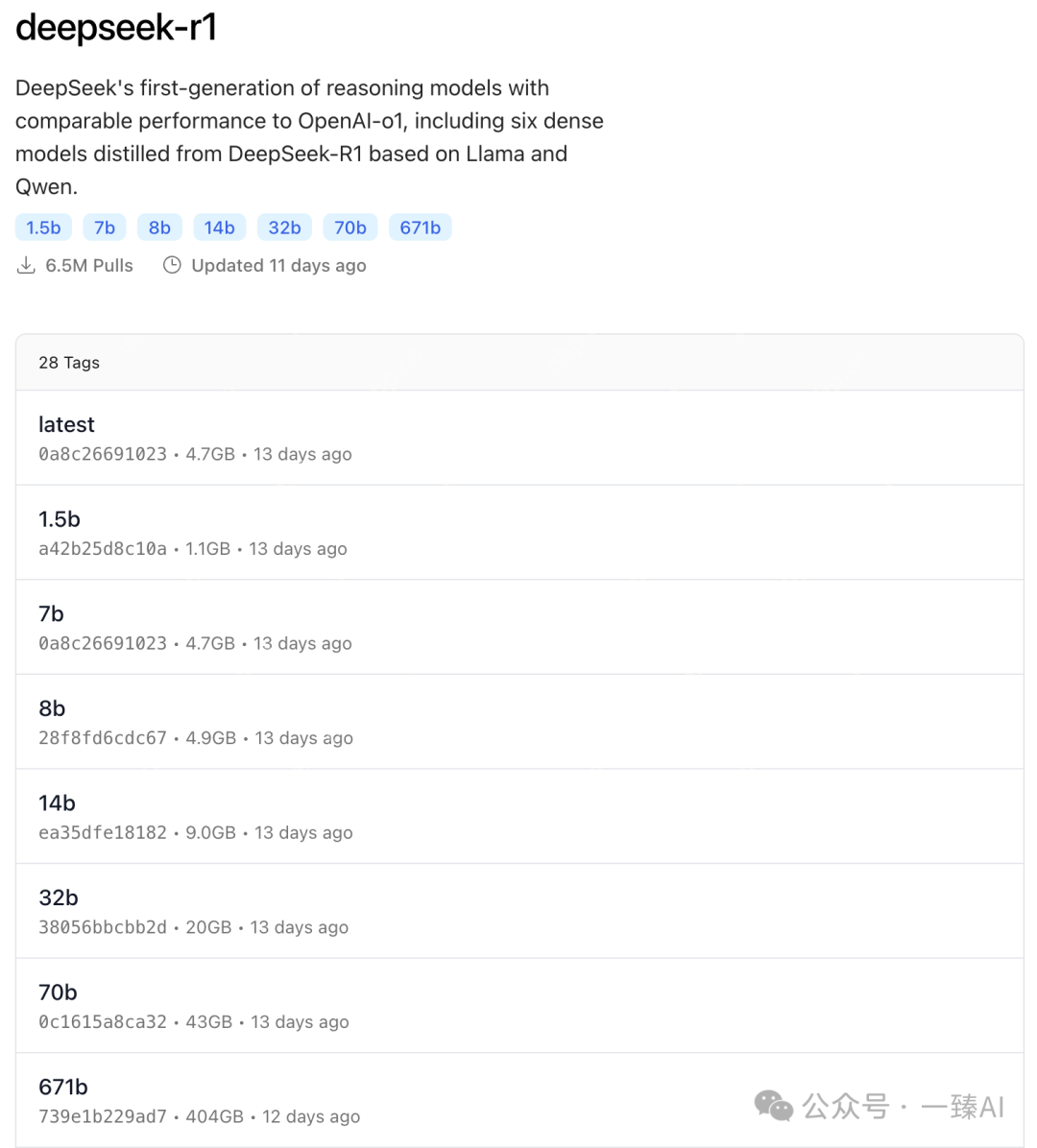

根据Ollama平台提供的DeepSeek-R1模型信息,以下是不同参数量模型的本地部署硬件要求和适用场景分析。

根据Ollama平台提供的DeepSeek-R1模型信息,以下是不同参数量模型的本地部署硬件要求和适用场景分析。

注:部分数据基于模型通用需求推测,具体以实际部署测试为准。

通用建议 量化优化:使用4-bit/8-bit量化可降低显存占用30-50%。 推理框架:搭配vLLM、TensorRT等加速库提升效率。 云部署:70B/671B建议优先考虑云服务以弹性扩展资源。 能耗注意:32B+模型需高功率电源(1000W+)和散热系统。

选择合适的DeepSeek版本不仅要考虑硬件配置,还要根据实际应用场景来决定。建议先从较小的模型开始尝试,逐步升级到更大的模型。这样可以在确保性能的同时,避免资源浪费。

选择合适的DeepSeek版本不仅要考虑硬件配置,还要根据实际应用场景来决定。建议先从较小的模型开始尝试,逐步升级到更大的模型。这样可以在确保性能的同时,避免资源浪费。

希望本文能帮助你更好地理解和选择适合自己的DeepSeek-R1模型版本。如果觉得有帮助,别忘了点赞三连哦!

以上就是一文读懂DeepSeek-R1本地部署配置要求(建议收藏)的详细内容,更多请关注php中文网其它相关文章!

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号