本教程介绍使用PP-LiteSeg模型对遥感图像道路进行分割的全流程。先配置含PaddlePaddle(不低于2.0.2)和PaddleSeg的环境,再用DeepGlobe数据集(分训练、验证、测试集),通过指定配置文件训练PP-LiteSeg和OCRNet模型,两者精度相近但前者速度快7倍。还涵盖模型预测、结果可视化及部署相关内容。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

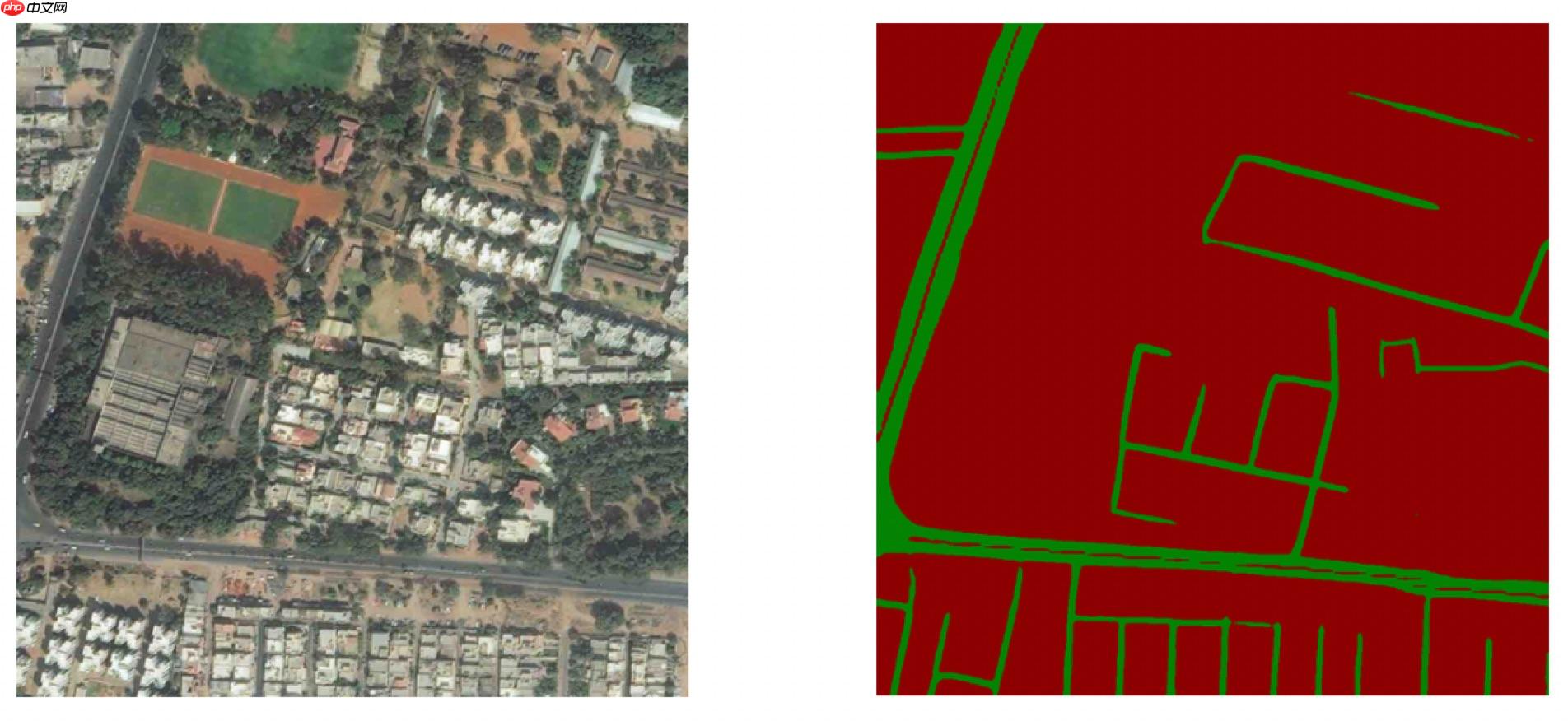

本教程使用PP-LiteSeg模型对遥感图像中的道路进行分割。

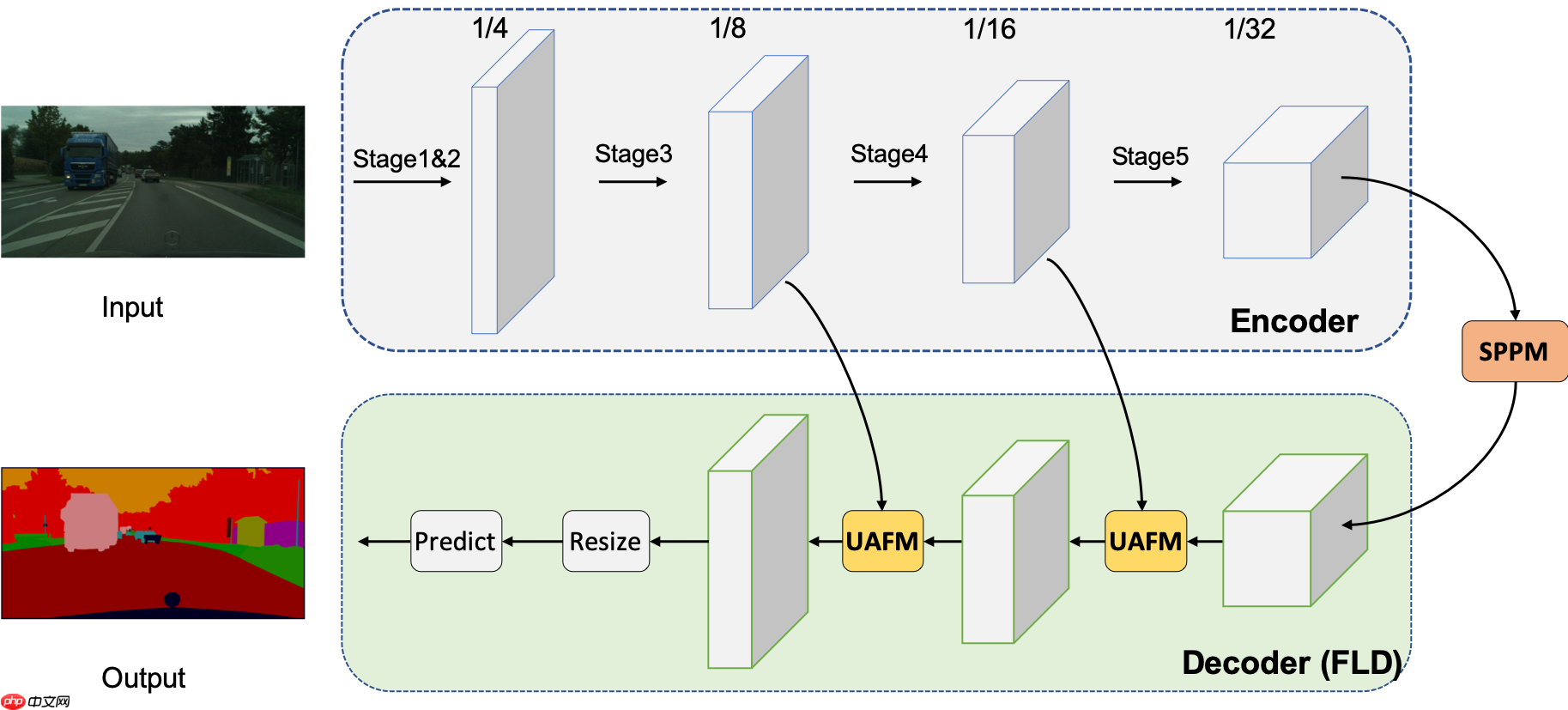

PP-LiteSeg模型是PaddleSeg团队自研的轻量级语义分割模型,结构如下。

PP-LiteSeg模型的具体介绍请参考链接,欢迎Star收藏,关注最新消息。

下面教程,将带大家完整的跑通模型训练、预测、可视化全流程。

请按照以下步骤配置相应的环境。

PaddlePaddle版本要求不低于 2.0.2, 本教程在PaddlePaddle 2.2.2下验证通过。

由于图像分割模型计算开销大,推荐安装GPU版本的PaddlePaddle。

如果在AI Studio上运行此项目,请选择使用GPU版本的环境,默认已经安装了PaddlePaddle。

如果在本地运行此项目,需要自行安装PaddlePaddle,详细安装教程请参考PaddlePaddle官网。

由于本教程使用的演示代码不是PaddleSeg核心功能,所以相关代码没有合入到PaddleSeg。

我们在~/work/目录下存放了PaddleSeg代码和本教程使用到的代码,可以直接解压使用。

%cd ~/work !rm -rf PaddleSeg !tar xf PaddleSeg.tar

执行如下命令,在环境中安装PaddleSeg需要的依赖库。

%cd ~/work/PaddleSeg !pip install -r requirements.txt

我们使用DeepGlobe开源数据集作为本教程的演示数据集。

DeepGlobe数据集已经整理成如下格式。

deepglobe ├── readme.md├── test.txt├── train ├── train.txt├── valid └── val.txt

我们将标注的遥感图片划分为训练集、验证集和测试集。

train.txt、val.txt、test.txt分别表示训练集、验证集和测试的划分,保存的内容如下。

train/81456_sat.jpg train/81456_mask.pngtrain/814574_sat.jpg train/814574_mask.pngtrain/814591_sat.jpg train/814591_mask.pngtrain/814649_sat.jpg train/814649_mask.png

整理好的Deepglobe数据集已经在~/data目录下,我们进行解压,然后链接到PaddleSeg/data目录下,用于后续训练测试使用。

# 解压数据%cd ~/data/data141168 !tar xf deepglobe.tar# 链接数据!mkdir -p ~/work/PaddleSeg/data !ln -s ~/data/data141168/deepglobe ~/work/PaddleSeg/data !ls ~/work/PaddleSeg/data

遥感道路分割的所有配置文件都在PaddleSeg/configs/road_seg/目录下。

PaddleSeg/configs/road_seg ├── deepglobe.yml├── ocrnet_hrnetw18_deepglobe_1024x1024_80k.yml├── pp_liteseg_stdc1_deepglobe_1024x1024_80k.yml└── pp_liteseg_stdc2_deepglobe_1024x1024_80k.yml

其中,deepglobe.yml文件定义了基础信息,比如训练集、测试集、优化器、学习率等。

其他文件定义了模型相关的信息,比如pp_liteseg_stdc1_deepglobe_1024x1024_80k.yml的内容如下。

_base_: './deepglobe.yml'model:

type: PPLiteSeg

backbone: type: STDC1

pretrained: https://bj.bcebos.com/paddleseg/dygraph/PP_STDCNet1.tar.gz

arm_out_chs: [32, 64, 128]

seg_head_inter_chs: [32, 64, 64]

loss:

types:

- type: OhemCrossEntropyLoss

min_kept: 260000

- type: OhemCrossEntropyLoss

min_kept: 260000

- type: OhemCrossEntropyLoss

min_kept: 260000

coef: [1, 1, 1]进入~/work/PaddleSeg目录,后续所有命令都在该目录下执行,结果也保存在该目录下。

在PaddleSeg目录下执行如下命令,开始训练PP-LiteSeg和OCRNet两个模型。 其中,输入参数config为配置文件的路径,如果需要训练其他模型,可以修改为其他配置文件。PaddleSeg完整的训练文档,请参考链接。

训练过程比较久,可以通过log输出查看需要的时间。训练结束后,模型权重保存在output对应的目录下。

注意:默认提供的配置文件是使用4卡进行训练,如果使用单卡训练,需要将学习率减小为1/4、iters增大4倍。

# train pp_liteseg%cd ~/work/PaddleSeg/

!python train.py \

--config configs/road_seg/pp_liteseg_stdc1_deepglobe_1024x1024_80k.yml \

--do_eval \

--num_workers 3 \

--save_interval 1000 \

--save_dir output/pp_liteseg_stdc1_deepglobe# train ocrnet%cd ~/work/PaddleSeg/

!python train.py \

--config configs/road_seg/ocrnet_hrnetw18_deepglobe_1024x1024_80k.yml \

--do_eval \

--num_workers 3 \

--save_interval 1000 \

--save_dir output/ocrnet_hrnetw18_deepglobe完成PP-LiteSeg和OCRNet模型的训练后,精度和速度如下表。

可以看到,PP-LiteSeg和OCRNet模型的精度基本相同,但是PP-LiteSeg的推理速度比OCRNet快了7倍。

| 模型 | Backbone | 精度mIoU (%) | 推理速度 FPS |

|---|---|---|---|

| PP-LiteSeg | STDC1 | 83.08 | 207.0 |

| OCRNet | HRNet_w18 | 83.15 | 26.8 |

加载训练好的模型权重,或者使用提供的模型权重,可以对测试集进行测试。

执行如下命令,下载已经训练好的模型权重,对deepglobe的测试集进行预测。

%cd ~/work/PaddleSeg

!mkdir pretrained

%cd pretrained

!wget https://paddleseg.bj.bcebos.com/dygraph/demo/pp_liteseg_stdc1_deepglobe.pdparams

!wget https://paddleseg.bj.bcebos.com/dygraph/demo/ocrnet_hrnetw18_deepglobe.pdparams

%cd ~/work/PaddleSeg

!python predict.py \

--config configs/road_seg/pp_liteseg_stdc1_deepglobe_1024x1024_80k.yml \

--model_path pretrained/pp_liteseg_stdc1_deepglobe.pdparams \

--image_path data/deepglobe/test.txt \

--save_dir output/pp_liteseg_stdc1_deepglobe_1024x1024_80k/pred_test导出预测模型进行部署,可以加载模型的推理速度。

PaddleSeg提供了详细教程,指导进行模型导出和模型部署,具体请参考链接。

请点击此处查看本环境基本用法.

Please click here for more detailed instructions.

以上就是【PaddleSeg实践范例】使用PP-LiteSeg进行遥感道路分割的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号