本文介绍利用PaddleGAN的Pix2pix模型生成遥感图像的方法。先介绍PaddleGAN及WHDLD数据集,再说明数据集准备与处理步骤,接着讲解用pix2pix模型训练的配置、过程,最后阐述预测及结果展示,实现了通过绘制标签生成对应遥感图像,解决数据不足问题。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

有时在使用一些遥感数据集时,常常会感觉数据不够用,能否用GAN的技术帮我们生成一些遥感图像呢?我说要有路,那便有了路~但由于技术原因一直没有做出。不过在此次GAN的七日打卡营中,我们找到了一个方便的方法。那就是使用PaddleGAN提供的Pix2pix模型,反向训练遥感分割数据集,这样我们就得到了一只神笔~当我画出一条路,那便有了一条路。具体如何做呢?请看下方分解。

# ! git clone https://gitee.com/paddlepaddle/PaddleGAN.git# ! unzip -oq data/data55589/WHDLD.zip# 只需要执行一次! mkdir -p Dataset ! unzip -oq /home/aistudio/data/data82195/WHDLD-GAN.zip -d Dataset ! mv Dataset/color-class.jpg work/ # 这里是要保证数据集文件夹里面干净,所以把类别和配色的对照表移动到work了

这是将WHDLD数据转化为WHDLD-GAN数据,可以不用运行了,可以使用自己的数据来处理。最后处理好的数据文件应该是这样的

dataset ├── train ├── val └── test

图片需要按照[生成风格, 原始图像]进行拼接

# ! mkdir -p Dataset/train# ! mkdir -p Dataset/val# import os# import random# import cv2# import numpy as np# from tqdm import tqdm# tmp_data_path = 'WHDLD/Images'# save_train_path = 'Dataset/train'# save_val_path = 'Dataset/val'# datas_name = os.listdir(tmp_data_path)# random.shuffle(datas_name)# for idx, data_name in enumerate(tqdm(datas_name)):# data_path = os.path.join(tmp_data_path, data_name)# target_path = data_path.replace('Images', 'ImagesPNG').replace('jpg', 'png')# data = cv2.imread(data_path) # 这里也应该转一下RGB,忘记了写,所以红色变成了水,蓝色变成了建筑# target = cv2.cvtColor(cv2.imread(target_path), cv2.COLOR_BGR2RGB)# img = np.concatenate((data, target), axis=1) # 主要就是这里需要将两个图像拼接起来# save_name = target_path.split('/')[-1]# if (idx + 1) % 20 != 0:# cv2.imwrite(os.path.join(save_train_path, save_name), img)# else:# cv2.imwrite(os.path.join(save_val_path, save_name), img)# ! rm -rf WHDLD # 减小空间这里我们使用的是pix2pix模型,只需要在PaddleGAN/configs中新建pix2pix_rs.yaml配置文件,然后将内容填入就好了(内容可以参考这个配置文件),其中几个地方简单一说。

epochs: 200 # 训练轮数output_dir: output_dir # 保存训练文件的文件夹enable_visualdl: true # 开启VDLmodel:

…… # 不用修改,使用官方提供的pix2pix即可dataset:

train:

name: PairedDataset

dataroot: ../Dataset/train # 数据集位置,因为数据集在PaddleGAN外面,所以需要../返回父级目录

num_workers: 4 # 不易过大,否则可能报错

batch_size: 1 # 批次大小

……

test:

name: PairedDataset

dataroot: ../Dataset/test # 同理

……lr_scheduler: # 学习率设置

……optimizer: # 生成器和判别器的优化器

……log_config:

……snapshot_config:

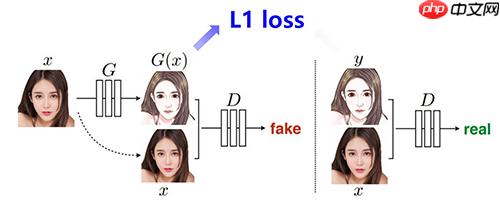

interval: 5 # 每多少轮保存一次模型参数Pix2pix利用成对的图片进行图像翻译,即输入为同一张图片的两种不同风格,可用于进行风格迁移。Pix2pix是在cGAN的基础上进行改进的,cGAN的生成网络不仅会输入一个噪声图片,同时还会输入一个条件作为监督信息,pix2pix则是把另外一种风格的图像作为监督信息输入生成网络中,这样生成的fake图像就会和作为监督信息的另一种风格的图像相关,从而实现了图像翻译的过程。

Pix2pix的优化目标包含2个部分。一部分是cGAN的优化目标;另一部分是L1距离,用来约束生成图像和真实图像之间的差异,这部分借鉴了其他基于GAN做图像翻译的思想,只不过这里用L1而不是L2,目的是减少生成图像的模糊。

Pix2pix网络结构:

优点:pix2pix巧妙的利用了GAN的框架来为“Image-to-Image translation”的一类问题提供了通用框架。利用U-Net提升细节,并且利用PatchGAN来处理图像的高频部分。

缺点:训练需要大量的成对图片。

%cd PaddleGAN# 恢复训练(想恢复训练需要修改yaml的轮数,因为已经训练到了200轮)# ! python -u tools/main.py --config-file configs/pix2pix_rs.yaml --resume ../data/data82195/epoch_200_checkpoint.pdparams# 重新训练# ! python -u tools/main.py --config-file configs/pix2pix_rs.yaml

/home/aistudio/PaddleGAN

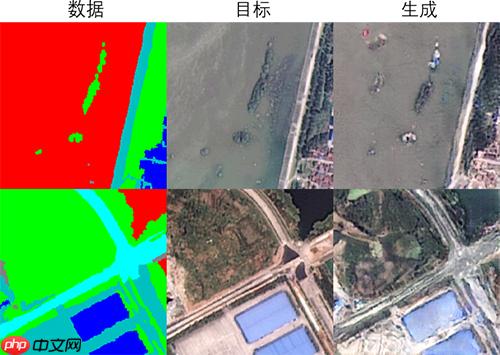

这是训练了8个小时的结果

ppgan.engine.trainer INFO: Epoch: 200/200, iter: 0/4693 lr: 1.980e-06 D_fake_loss: 0.048 D_real_loss: 0.580 G_adv_loss: 4.508 G_L1_loss: 11.564 batch_cost: 0.03402 sec reader_cost: 0.00107 sec ips: 29.39492 images/s eta: 0:00:00

这是VDL看到的生成结果和原始的遥感影像

预测的数据也需要组成拼接的数据,数据的左边随便放点啥。我想不使用配置文件的话应该不用将预测图像也进行拼接,奈何PaddleGAN小白,就先按照这个来吧~需要预测的内容可以自己使用PS等等进行绘制,使用的颜色参考数据集中的color-class.jpg(现在被移动到work目录下了),然后放到test文件夹下就好啦。下面我随便画了两张看看这只神笔能画出怎样的遥感影像~

【左】这是月亮形状的湖在裸地中,周围有几条奇奇怪怪的路。

【右】螺旋形状的路通到一个湖中小岛,岛上被植被包围,中间就一个建筑。

! python tools/main.py --config-file configs/pix2pix_rs.yaml --evaluate-only --load ../data/data82195/epoch_200_checkpoint.pdparams

/opt/conda/envs/python35-paddle120-env/lib/python3.7/site-packages/setuptools/depends.py:2: DeprecationWarning: the imp module is deprecated in favour of importlib; see the module's documentation for alternative uses

import imp

[04/19 10:38:33] ppgan INFO: Configs: {'epochs': 200, 'output_dir': 'output_dir/pix2pix_rs-2021-04-19-10-38', 'enable_visualdl': True, 'model': {'name': 'Pix2PixModel', 'generator': {'name': 'UnetGenerator', 'norm_type': 'batch', 'input_nc': 3, 'output_nc': 3, 'num_downs': 8, 'ngf': 64, 'use_dropout': False}, 'discriminator': {'name': 'NLayerDiscriminator', 'ndf': 64, 'n_layers': 3, 'input_nc': 6, 'norm_type': 'batch'}, 'direction': 'b2a', 'pixel_criterion': {'name': 'L1Loss', 'loss_weight': 100}, 'gan_criterion': {'name': 'GANLoss', 'gan_mode': 'vanilla'}}, 'dataset': {'train': {'name': 'PairedDataset', 'dataroot': '../Dataset/train', 'num_workers': 4, 'batch_size': 1, 'preprocess': [{'name': 'LoadImageFromFile', 'key': 'pair'}, {'name': 'SplitPairedImage', 'key': 'pair', 'paired_keys': ['A', 'B']}, {'name': 'Transforms', 'input_keys': ['A', 'B'], 'pipeline': [{'name': 'Resize', 'size': [286, 286], 'interpolation': 'bicubic', 'keys': ['image', 'image']}, {'name': 'PairedRandomCrop', 'size': [256, 256], 'keys': ['image', 'image']}, {'name': 'PairedRandomHorizontalFlip', 'prob': 0.5, 'keys': ['image', 'image']}, {'name': 'Transpose', 'keys': ['image', 'image']}, {'name': 'Normalize', 'mean': [127.5, 127.5, 127.5], 'std': [127.5, 127.5, 127.5], 'keys': ['image', 'image']}]}]}, 'test': {'name': 'PairedDataset', 'dataroot': '../Dataset/test', 'num_workers': 4, 'batch_size': 1, 'preprocess': [{'name': 'LoadImageFromFile', 'key': 'pair'}, {'name': 'SplitPairedImage', 'key': 'pair', 'paired_keys': ['A', 'B']}, {'name': 'Transforms', 'input_keys': ['A', 'B'], 'pipeline': [{'name': 'Resize', 'size': [256, 256], 'interpolation': 'bicubic', 'keys': ['image', 'image']}, {'name': 'Transpose', 'keys': ['image', 'image']}, {'name': 'Normalize', 'mean': [127.5, 127.5, 127.5], 'std': [127.5, 127.5, 127.5], 'keys': ['image', 'image']}]}]}}, 'lr_scheduler': {'name': 'LinearDecay', 'learning_rate': 0.0002, 'start_epoch': 100, 'decay_epochs': 100, 'iters_per_epoch': 1}, 'optimizer': {'optimG': {'name': 'Adam', 'net_names': ['netG'], 'beta1': 0.5}, 'optimD': {'name': 'Adam', 'net_names': ['netD'], 'beta1': 0.5}}, 'log_config': {'interval': 100, 'visiual_interval': 500}, 'snapshot_config': {'interval': 5}, 'is_train': False, 'timestamp': '-2021-04-19-10-38'}

W0419 10:38:33.788132 523 device_context.cc:362] Please NOTE: device: 0, GPU Compute Capability: 7.0, Driver API Version: 10.1, Runtime API Version: 10.1

W0419 10:38:33.793035 523 device_context.cc:372] device: 0, cuDNN Version: 7.6.

[04/19 10:38:45] ppgan.engine.trainer INFO: Loaded pretrained weight for net netG

[04/19 10:38:45] ppgan.engine.trainer INFO: Loaded pretrained weight for net netD

[04/19 10:38:53] ppgan.engine.trainer INFO: Test iter: [0/2]看看我们瞎画的艺术能生成怎样的遥感影像。

import cv2import matplotlib.pyplot as plt

data1 = 'output_dir/pix2pix_rs-2021-04-19-10-38/visual_test/diy0001_real_A.png'target1 = 'output_dir/pix2pix_rs-2021-04-19-10-38/visual_test/diy0001_fake_B.png'data2 = 'output_dir/pix2pix_rs-2021-04-19-10-38/visual_test/diy0002_real_A.png'target2 = 'output_dir/pix2pix_rs-2021-04-19-10-38/visual_test/diy0002_fake_B.png'data1 = cv2.cvtColor(cv2.imread(data1), cv2.COLOR_BGR2RGB)

target1 = cv2.cvtColor(cv2.imread(target1), cv2.COLOR_BGR2RGB)

data2 = cv2.cvtColor(cv2.imread(data2), cv2.COLOR_BGR2RGB)

target2 = cv2.cvtColor(cv2.imread(target2), cv2.COLOR_BGR2RGB)

plt.figure(figsize=(10, 10))

plt.subplot(221);plt.imshow(data1);plt.title('data')

plt.subplot(222);plt.imshow(target1);plt.title('generate')

plt.subplot(223);plt.imshow(data2)

plt.subplot(224);plt.imshow(target2)

plt.show()<Figure size 720x720 with 4 Axes>

以上就是从零实践基于PaddleGAN的反向学习分割数据生成遥感图像生成的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号