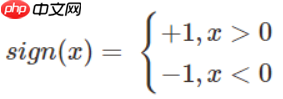

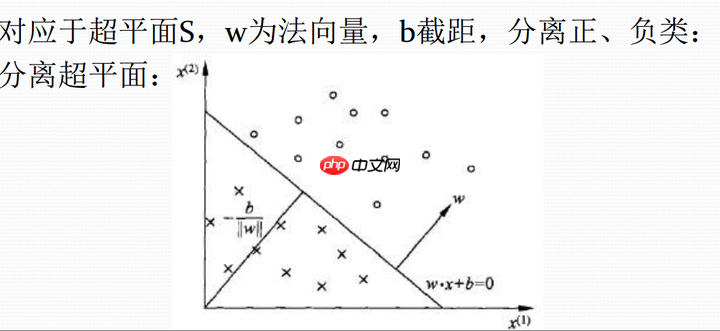

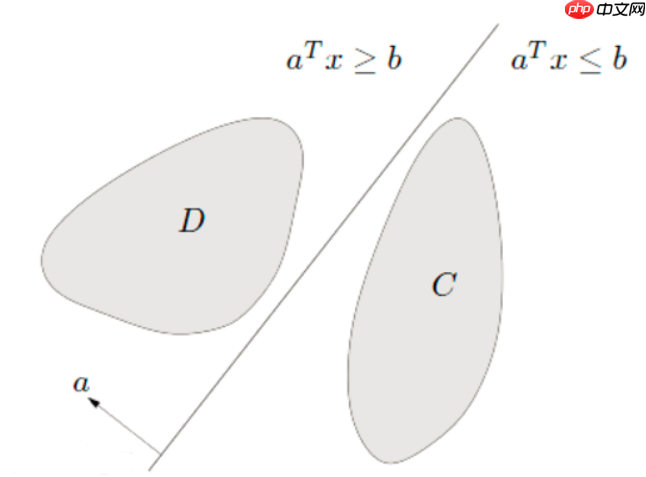

感知机是二分类的线性分类模型,输入为实例的特征向量,输出为实例的类别(取+1和-1)。感知机对应于输入空间中将实例划分为两类的分离超平面。感知机旨在求出该超平面,为求得超平面导入了基于误分类的损失函数,利用梯度下降法对损失函数进行最优化。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

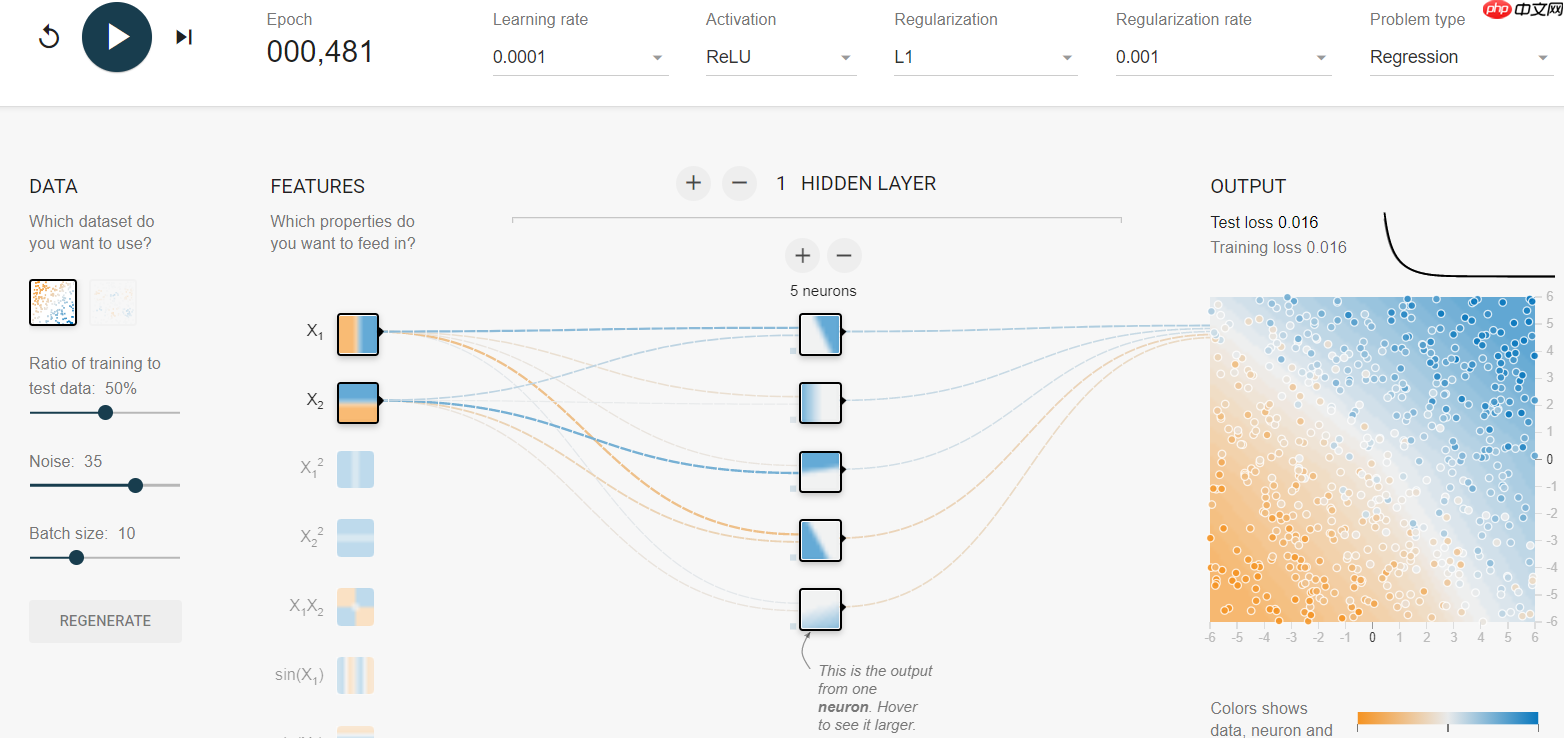

同时介绍一个可视化实验网址,效果如下:网站链接

∣w∣1∣w∗x0+b∣

−∣w∣1yi(w∗xi+b)

−∣w∣1Σyi(w∗xi+b)

L(w,b)=−Σyi(w∗xi+b)

以iris数据集中两个分类的数据和[sepal length,sepal width]作为特征进行代码举例

import pandas as pdimport numpy as npfrom sklearn.datasets import load_irisimport matplotlib.pyplot as plt %matplotlib inline

# load datairis = load_iris() df = pd.DataFrame(iris.data, columns=iris.feature_names) df['label'] = iris.target

#df.columns = ['sepal length', 'sepal width', 'petal length', 'petal width', 'label'] df.label.value_counts()

2 50 1 50 0 50 Name: label, dtype: int64

plt.scatter(df[:50]['sepal length'], df[:50]['sepal width'], label='0')

plt.scatter(df[50:100]['sepal length'], df[50:100]['sepal width'], label='1')

plt.xlabel('sepal length')

plt.ylabel('sepal width')

plt.legend()<matplotlib.legend.Legend at 0x7f70182f1490>

<Figure size 432x288 with 1 Axes>

data = np.array(df.iloc[:100, [0, 1, -1]])

X, y = data[:,:-1], data[:,-1]

y = np.array([1 if i == 1 else -1 for i in y])

# 数据线性可分,二分类数据# 此处为一元一次线性方程class Model:

def __init__(self):

self.w = np.ones(len(data[0])-1, dtype=np.float32)

self.b = 0

self.l_rate = 0.1

# self.data = data

def sign(self, x, w, b):

y = np.dot(x, w) + b return y

# 随机梯度下降法

def fit(self, X_train, y_train):

is_wrong = False

while not is_wrong:

wrong_count = 0

for d in range(len(X_train)):

X = X_train[d]

y = y_train[d] if y * self.sign(X, self.w, self.b) <= 0:

self.w = self.w + self.l_rate*np.dot(y, X)

self.b = self.b + self.l_rate*y

wrong_count += 1

if wrong_count == 0:

is_wrong = True

return 'Perceptron Model!'

def score(self):

passperceptron = Model() perceptron.fit(X, y)

'Perceptron Model!'

x_points = np.linspace(4, 7,10)

y_ = -(perceptron.w[0]*x_points + perceptron.b)/perceptron.w[1]

plt.plot(x_points, y_)

plt.plot(data[:50, 0], data[:50, 1], 'bo', color='blue', label='0')

plt.plot(data[50:100, 0], data[50:100, 1], 'bo', color='orange', label='1')

plt.xlabel('sepal length')

plt.ylabel('sepal width')

plt.legend()<matplotlib.legend.Legend at 0x7f7f43472150>

<Figure size 432x288 with 1 Axes>

from sklearn.linear_model import Perceptron

clf = Perceptron(fit_intercept=False,max_iter=5000, shuffle=False) clf.fit(X, y)

Perceptron(alpha=0.0001, class_weight=None, early_stopping=False, eta0=1.0,

fit_intercept=False, max_iter=5000, n_iter_no_change=5, n_jobs=None,

penalty=None, random_state=0, shuffle=False, tol=0.001,

validation_fraction=0.1, verbose=0, warm_start=False)# Weights assigned to the features.print(clf.coef_)

[[ 16.3 -24.2]]

# 截距 Constants in decision function.print(clf.intercept_)

[0.]

x_ponits = np.arange(4, 8)

y_ = -(clf.coef_[0][0]*x_ponits + clf.intercept_)/clf.coef_[0][1]

plt.plot(x_ponits, y_)

plt.plot(data[:50, 0], data[:50, 1], 'bo', color='blue', label='0')

plt.plot(data[50:100, 0], data[50:100, 1], 'bo', color='orange', label='1')

plt.xlabel('sepal length')

plt.ylabel('sepal width')

plt.legend()<matplotlib.legend.Legend at 0x7f7ef401f410>

<Figure size 432x288 with 1 Axes>

以上就是“机器学习”系列之Perceptron(感知机)的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号