近日,一个开发团队推出并开源了一款全新的角色融合生成模型——mimix,成功实现了不同角色在共享场景中的自然交互与无缝融合。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

当前,文生视频技术已趋于成熟,诸如Veo 3、Sora等主流模型均能高效完成从文本描述到动态视频的生成,并支持基础的动作交互。

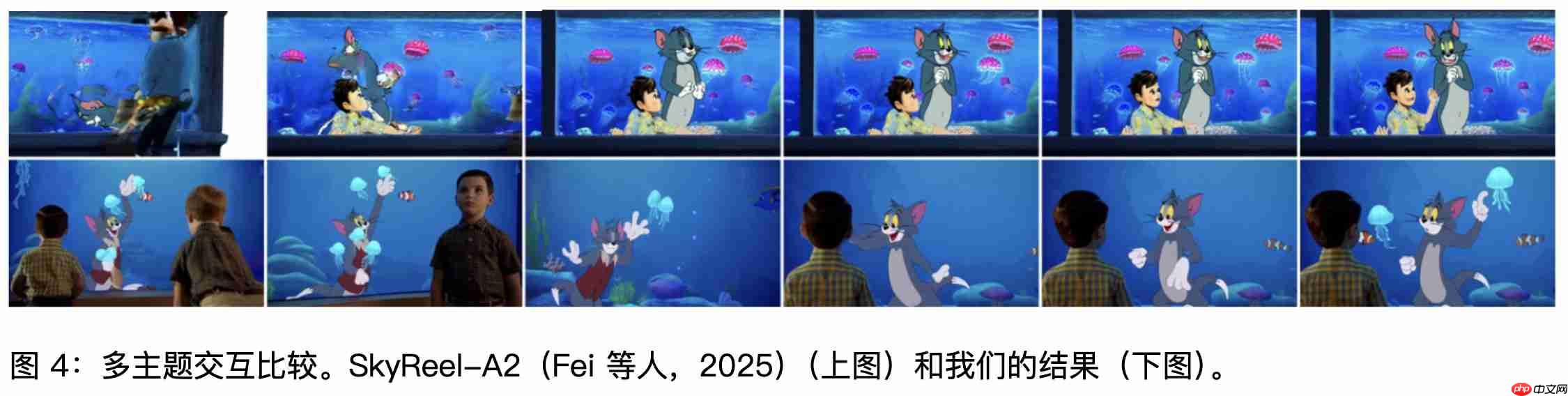

而MIMIX的目标更为聚焦:让来自不同世界的角色能够在一个统一场景中自然共存。例如,将猫和老鼠带入憨豆先生的生活环境中。其核心挑战在于,在确保每个角色保留自身独特身份特征与行为模式的同时,还能与其他角色进行连贯且符合情境逻辑的互动。

此外,现有AI系统在处理多角色混合时普遍存在“风格漂移”问题,容易引发视觉幻觉,导致某一角色被不自觉地同化为其他角色的艺术风格。比如,憨豆先生可能意外变成猫和老鼠动画中的画风。

为应对上述难题,研发团队构建了一个创新框架,引入跨角色嵌入(CCE)机制,用于从多模态数据中学习角色的身份信息与行为逻辑;同时采用跨角色增强(CCA)策略,通过合成包含多个角色共现及混合风格的数据,进一步丰富训练样本的多样性。

为了使AI准确维持角色风格,系统需接受大量高质量数据训练,涵盖角色外貌、动作规律以及在各类环境下的行为习惯。为此,团队还设计了一种新型数据格式,专门用于记录和分离角色身份信息与场景背景,确保在推理阶段AI可以精准识别并持续保持角色特性,不受所处环境干扰。

据悉,项目组收集了《憨豆先生》《汤姆和杰瑞》《我们裸熊》《小谢尔顿》四部影视作品共计81小时的视频内容,构建专属数据集,对其中52000个片段、涉及10个主要角色进行了深度建模。通过对角色身份与艺术风格进行精细标注,最终实现了可控的多角色混合视频生成。

MIMIX的问世,为影视二次创作乃至原创内容生产打开了前所未有的想象空间。理论上,只要提供充足且高质量的训练素材,创作者便能生成出与原作风格高度一致的高保真再创作视频,实现如“关公战秦琼”般跨越时空的角色联动。

当然,与所有前沿技术一样,MIMIX仍面临现实挑战。其表现效果高度依赖大规模、精标注的数据支持。当训练资源有限时,生成结果的稳定性是否会下降?未来的关键方向之一便是降低数据门槛——模型是否能够进化至直接从互联网海量未标注素材中自主学习并完成角色提取与风格识别,从而实现快速、低成本的多角色视频合成?

前景值得期待。或许在不久将来,随着模型不断优化升级,普通用户仅需上传几张图片或一段短视频,就能将自己的喜爱角色融入经典影视剧场景,甚至独立创作出一部由AI驱动的、多角色互动的全新叙事作品。MIMIX已然轻轻推开了这扇未来之门,门后世界,正待探索。

以上就是AI疯了!这个模型让所有IP角色同台飙戏的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号