10月16日资讯,随着人工智能产业的迅猛发展,对算力的需求呈现爆发式增长。无论是依托先进硬件技术,还是构建超大规模ai集群,各大企业正全力增强其ai运算实力。但与此同时,这一趋势也引发了前所未有的能源消耗挑战。

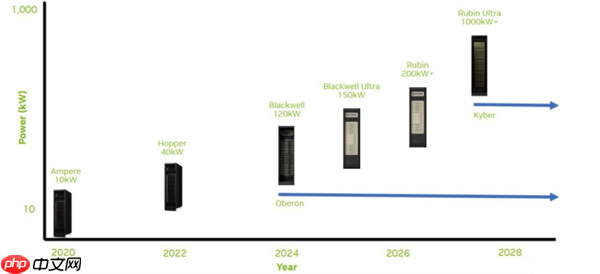

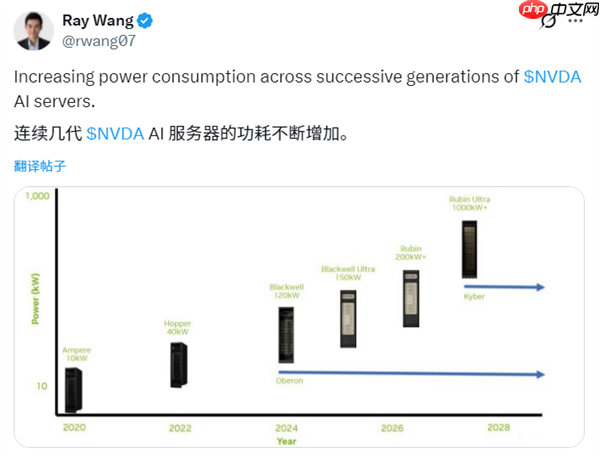

根据分析师Ray Wang提供的数据,NVIDIA的AI服务器平台在代际演进过程中,功耗显著攀升——从Ampere架构到Kyber架构,短短八年时间,整体功耗增长高达100倍。

这种急剧上升的能耗主要源于两个方面:一是每机架部署的GPU数量持续增加,二是单个GPU的热设计功耗(TDP)不断提升。

以Hopper架构为例,其典型机架运行功率为10KW;而到了Blackwell架构,由于GPU密度大幅提升,单机架功耗已接近120KW。

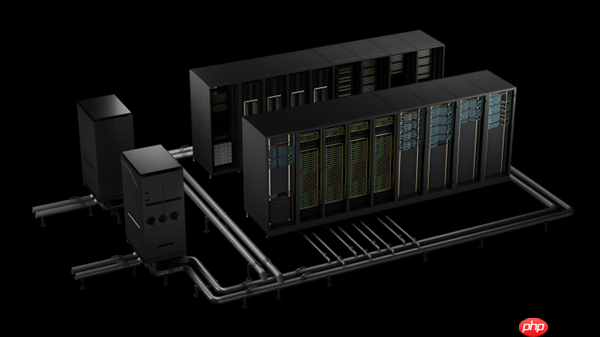

除了GPU本身的升级,诸如新一代NVLink/NVSwitch互联架构、优化后的机架设计以及更高的持续利用率,也在推动超大规模数据中心整体能耗飞速上涨。

当前,科技巨头之间正展开一场“AI机架规模”的激烈竞争,衡量计算实力的标准已不再仅仅是FLOPS,而是转向了“吉瓦(GW)”级别的电力消耗指标。包括OpenAI和Meta在内的多家公司,已规划在未来数年内新增超过10吉瓦的AI算力支持。

作为参照,1吉瓦的电力足以满足约100万个美国家庭的日常用电需求。如今,一些顶级AI数据中心的总能耗水平,已堪比一个中等国家或数个美国大州的用电总量。

此外,国际能源署(IEA)在其2025年发布的《能源与AI》研究报告中预测,到2030年,全球AI系统的能耗将翻一番,增速约为电网扩容速度的四倍。

以上就是AI成“能源黑洞”:NVIDIA AI服务器功耗8年激增100倍!的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号