本文为经过自动驾驶之心公众号授权转载,请在转载时与出处联系

目前,基于Transformer结构的算法模型已经在计算机视觉(CV)领域产生了极大的影响。它们在许多基本的计算机视觉任务上超越了以前的卷积神经网络(CNN)算法模型。以下是我找到的最新的不同基础计算机视觉任务的LeaderBoard榜单排名,通过LeaderBoard可以看出Transformer算法模型在各类计算机视觉任务上的统治地位

首先是在ImageNet上的LeaderBoard,通过榜单可以看出,前五名当中,每个模型都使用了Transformer结构,而CNN结构只有部分使用,或者采用和Transformer相结合的方式。

图像分类任务的LeaderBoard

接下来是在COCO test-dev上的LeaderBoard,通过榜单可以看出,前五名当中,一半以上都是基于DETR这类算法结构进行延伸的。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

目标检测任务的LeaderBoard

目标检测任务的LeaderBoard

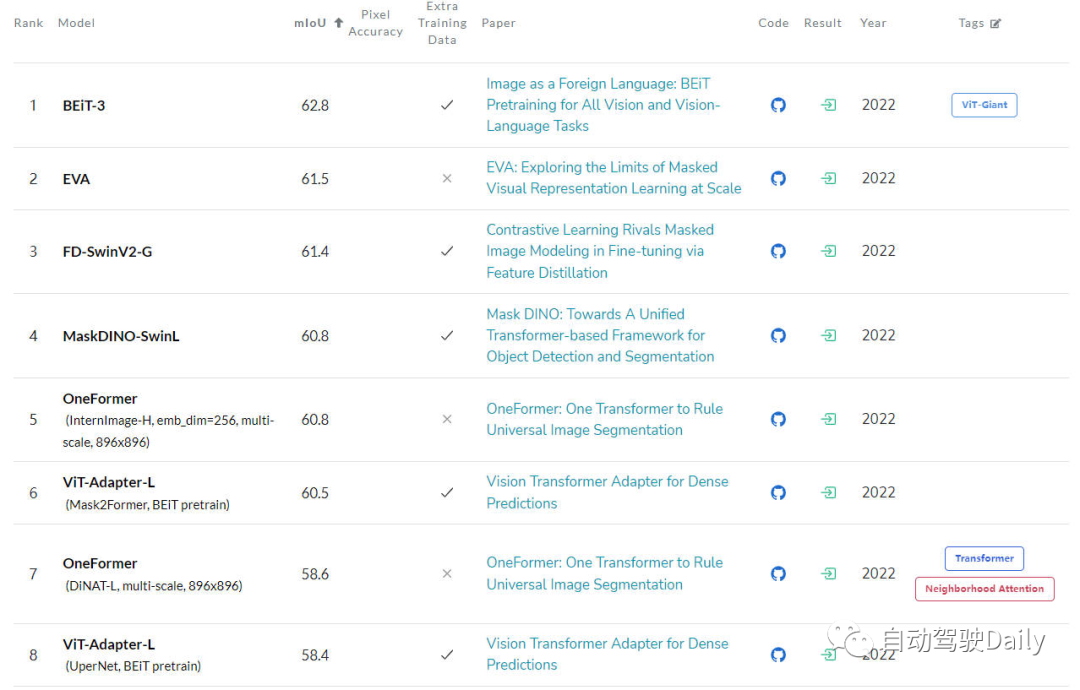

最后是在ADE20K val上的LeaderBoard,通过榜单也可以看出,在榜单的前几名中,Transformer结构依旧占据是当前的主力军。

语义分割任务的LeaderBoard

语义分割任务的LeaderBoard

尽管Transformer在中国目前展现出了巨大的发展潜力,但是目前的计算机视觉社区还没有完全掌握Vision Transformer的内部工作原理,也没有掌握其决策(输出的预测结果)的基础,因此对其可解释性的需求逐渐凸显出来。只有了解这类模型是如何做出决策的,才能提高它们的性能,并建立对人工智能系统的信任

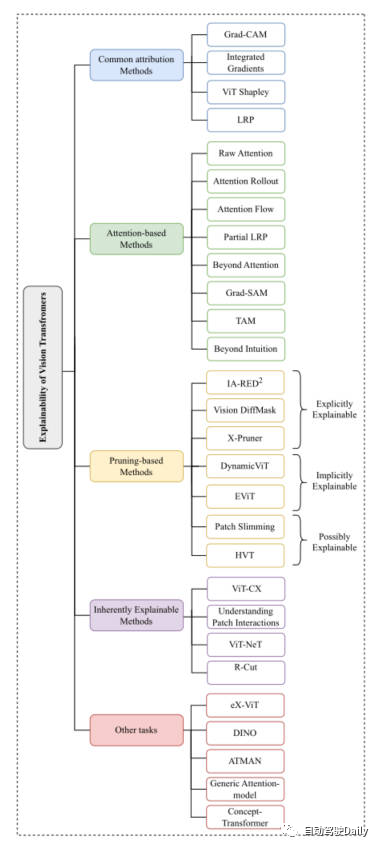

本文的主要目的是研究Vision Transformer的不同可解释性方法,并根据不同算法的研究动机、结构类型以及应用场景进行分类,从而形成一篇综述文章

因为刚才提到,Vision Transformer的结构在各类基础的计算机视觉任务中都取得了非常不错的成绩。所以之后计算机视觉社区涌现出了很多方法来增强它的可解释性。本文我们主要以分类任务为主线,从Common Attribution Methods、Attention-based Methods、Pruning-based Methods、Inherently Explainable Methods、Other Tasks这五个方面中,挑选出最新以及经典的工作进行介绍。这里放一下论文中出现的思维导图,大家可以根据自身感兴趣的内容,进行更加细致的阅读~

本文思维导图

基于属性方法的解释通常从模型的输入特征如何逐步得到最终输出结果的过程入手进行解释。这类方法主要用于衡量模型的预测结果与输入特征之间的相关性

在这些方法中,例如Grad-CAM以及Integrated Gradients算法是直接应用于了基于视觉Transformer的算法上。一些其他的方法像SHAP和Layer-Wise Relevance Propagation(LRP)已经被用来探索基于ViT的架构上了。但是由于SHAP这类方法到的计算成本非常大,所以最近的ViT Shapely算法被设计出来用于适配ViT的相关应用研究。

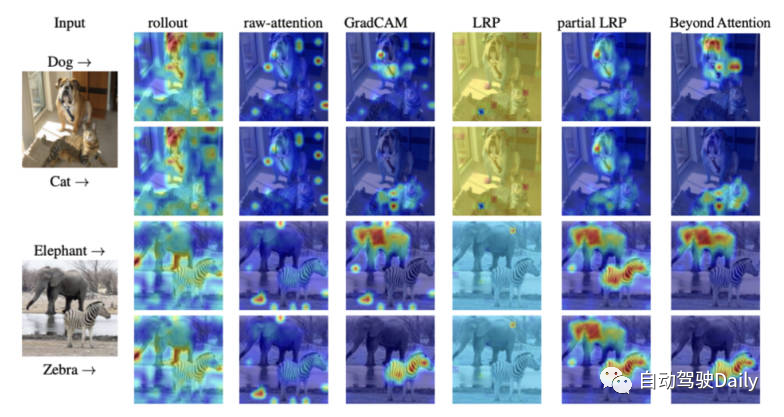

Vision Transformer正是通过其注意力机制获得了强大的特征提取能力。在基于注意力的可解释性方法中,对注意力权重结果进行可视化是一种非常有效的方法。本文将介绍几种可视化技术

最后放一张不同可解释性方法的注意力可视化图,大家可以自行感受一下不同可视化方法的区别。

不同可视化方法的注意力图对比

剪枝是一种非常有效的方法,被广泛应用于优化transformer结构的效率和复杂性。剪枝方法通过对冗余或者没用的信息进行删减,从而降低模型的参数量和计算复杂度。虽然剪枝算法侧重于提高模型的计算效率,但是该类算法依旧可以实现对模型的可解释性。

本文中针对基于Vision-Transformer的剪枝方法,大体可以分成三大类:explicitly explainable(显式可解释)、implicitly explainable(隐式可解释)、possibly explainable(可能可解释)。

在不同的可解释方法中,有一类方法主要是开发能够内在地解释算法模型,然而,这些模型通常难以达到与更复杂的黑盒模型相同的精度水平。因此,必须在可解释性和性能之间考虑谨慎的平衡。接下来对一些经典的工作进行简要的介绍。

基于ViT的架构在探索中仍然需要对其他计算机视觉任务进行解释。目前已经提出了一些专门针对其他任务的可解释性方法,下面将介绍相关领域的最新工作

目前,基于Transformer架构的算法模型在各类计算机视觉任务上取得了非常出色的成绩。然而,就如何利用可解释性方法促进模型调试和改进、提高模型的公平性和可靠性而言,特别是在ViT应用中,目前缺乏明显的研究

本文旨在通过图像分类任务,对基于Vision Transformer的可解释性算法模型进行归类整理,以帮助读者更好地理解这类模型的架构,希望对大家有所帮助

需要重写的是:原文链接:https://mp.weixin.qq.com/s/URkobeRNB8dEYzrECaC7tQ

以上就是更深层的理解视觉Transformer, 对视觉Transformer的剖析的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号