开源moe模型,终于迎来首位国产选手!

它的表现完全不输给密集的Llama 2-7B模型,计算量却仅有40%。

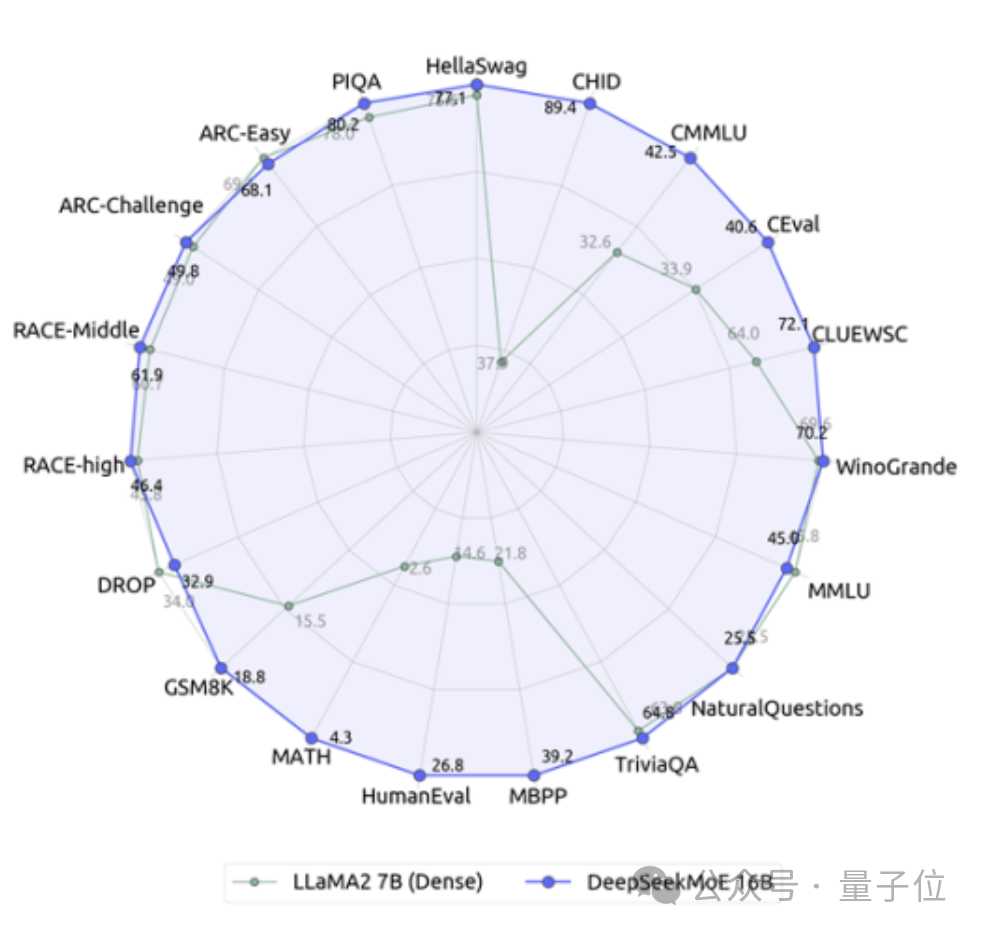

这个模型堪称19边形战士,特别是在数学和代码能力上对Llama形成了碾压。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

它就是深度求索团队最新开源的160亿参数专家模型DeepSeek MoE。

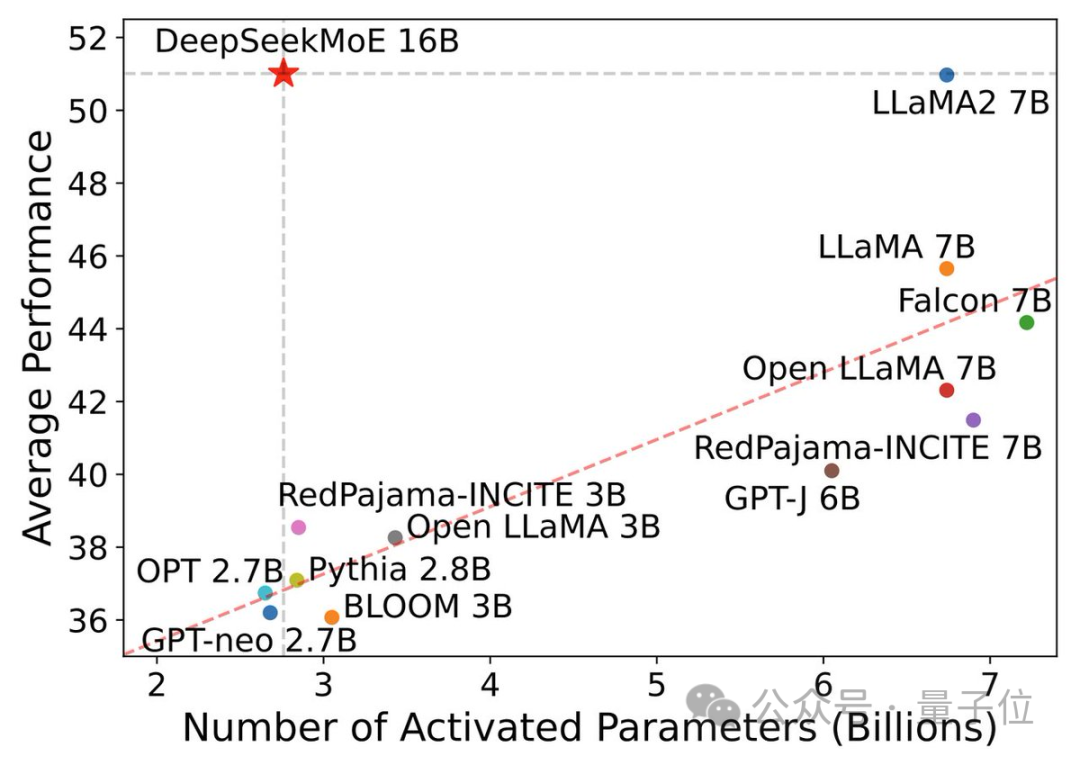

除了性能上表现优异,DeepSeek MoE主打的就是节约计算量。

在这张表现-激活参数量图中,它“一枝独秀”地占据了左上角的大片空白区。

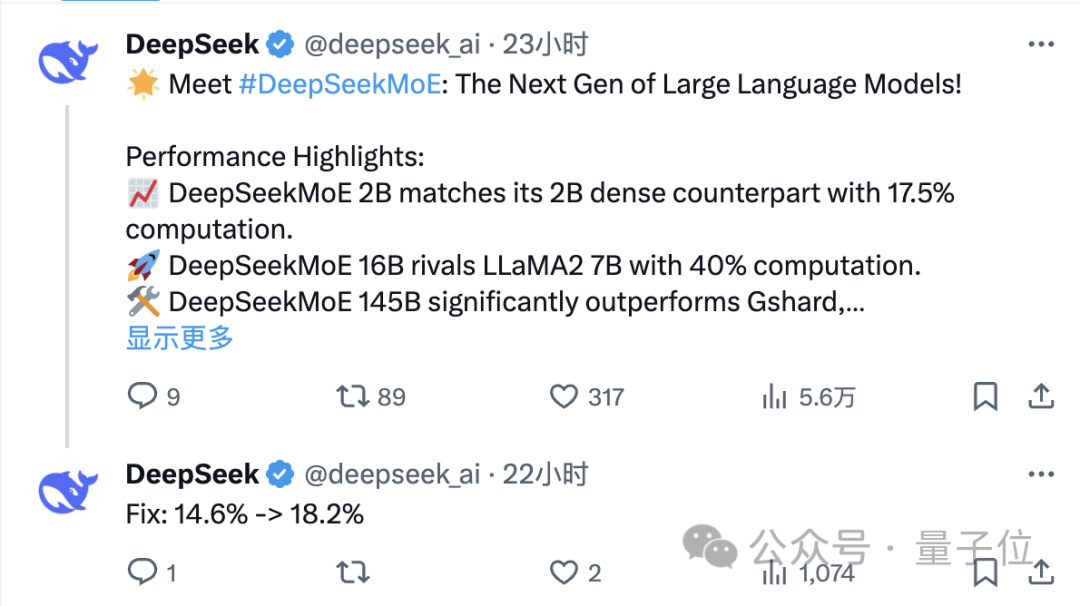

发布仅一天,DeepSeek团队在X上的推文就有大量转发关注。

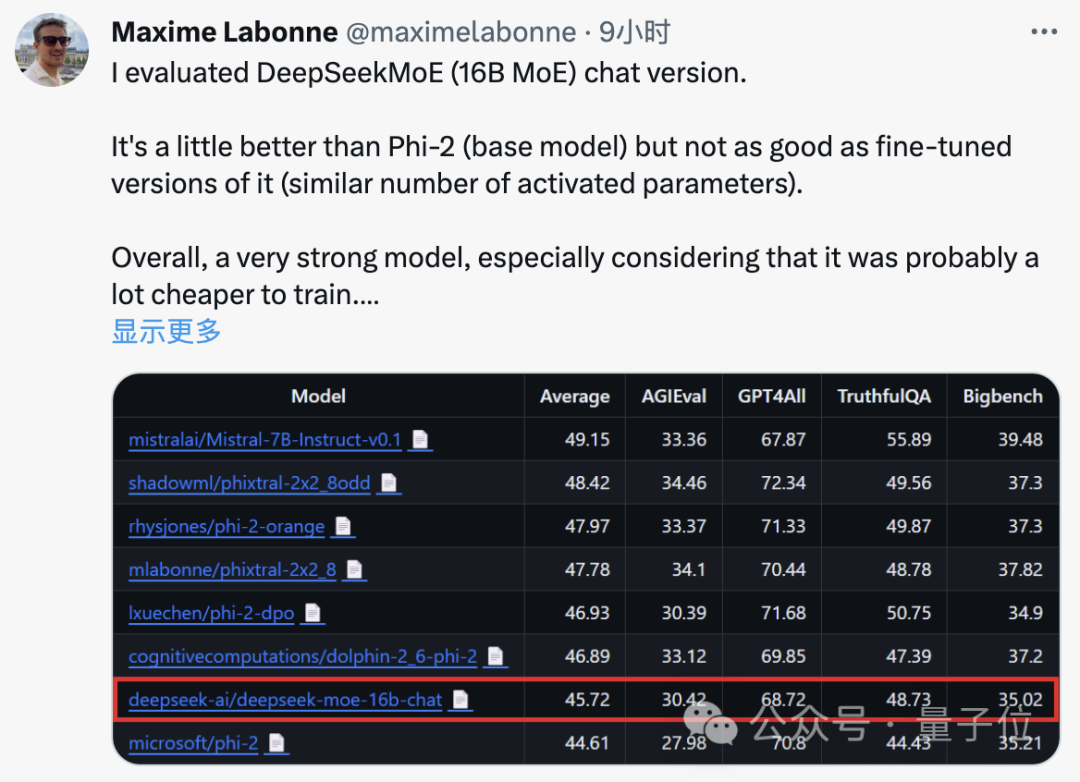

JP摩根的机器学习工程师Maxime Labonne测试后也表示,DeepSeek MoE的chat版本表现要略胜于微软的“小模型”Phi-2。

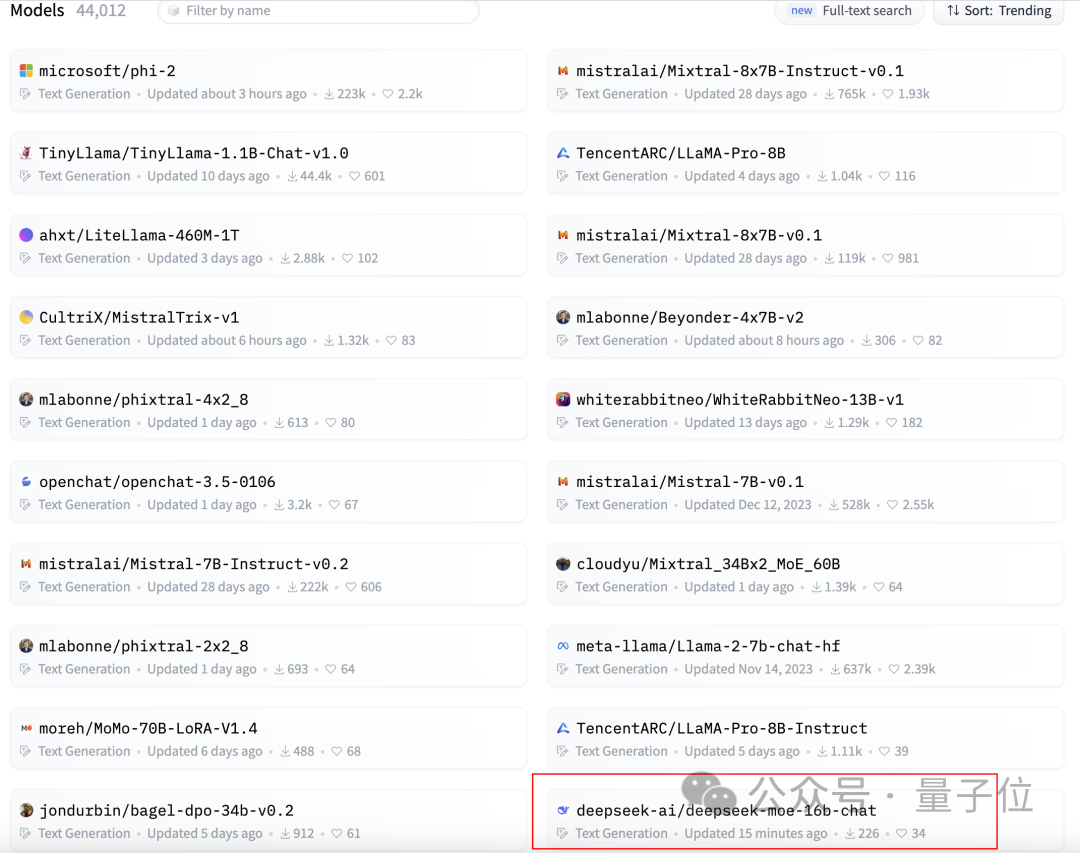

同时,DeepSeek MoE还在GitHub上获得了300+星标,并登上了Hugging Face文本生成类模型排行榜的首页。

那么,DeepSeek MoE的具体表现究竟怎么样呢?

DeepSeek MoE目前推出的版本参数量为160亿,实际激活参数量大约是28亿。

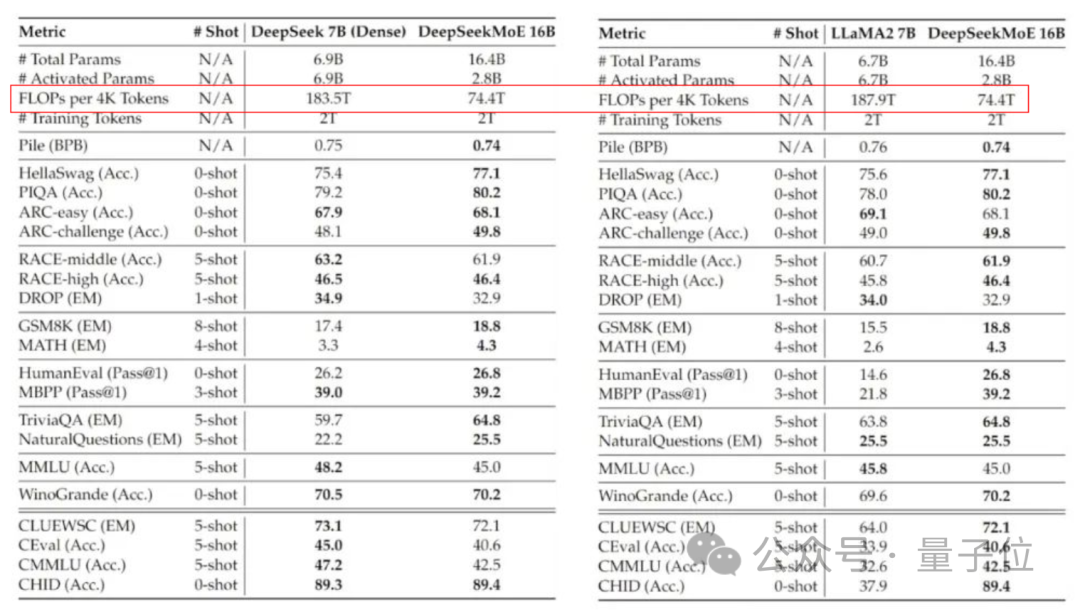

与自家的7B密集模型相比,二者在19个数据集上的表现各有胜负,但整体比较接近。

而与同为密集模型的Llama 2-7B相比,DeepSeek MoE在数学、代码等方面还体现出来明显的优势。

但两种密集模型的计算量都超过了180TFLOPs每4k token,DeepSeek MoE却只有74.4TFLOPs,只有两者的40%。

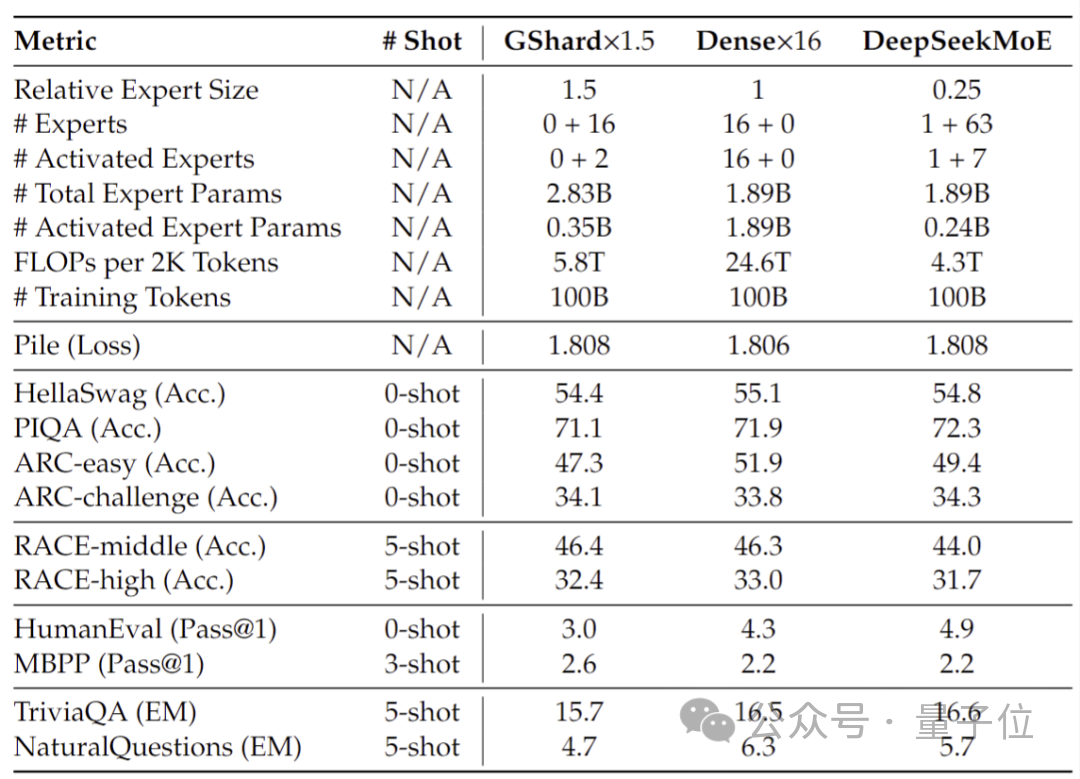

在20亿参数量时进行的性能测试显示,DeepSeek MoE同样能以更少的计算量,达到与1.5倍参数量、同为MoE模型的GShard 2.8B相当甚至更好的效果。

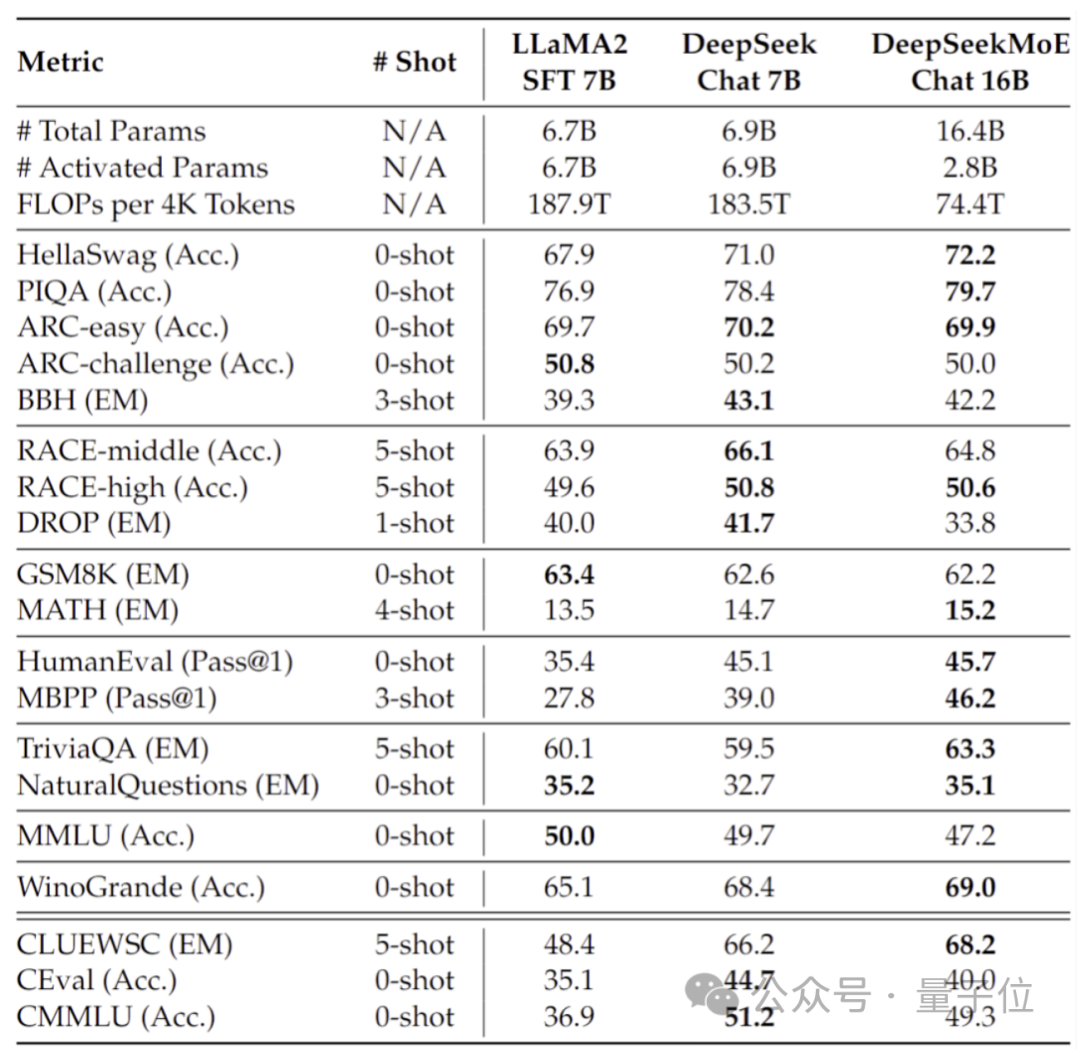

此外深度求索团队还基于SFT微调除了DeepSeek MoE的Chat版本,表现同样接近自家密集版本和Llama 2-7B。

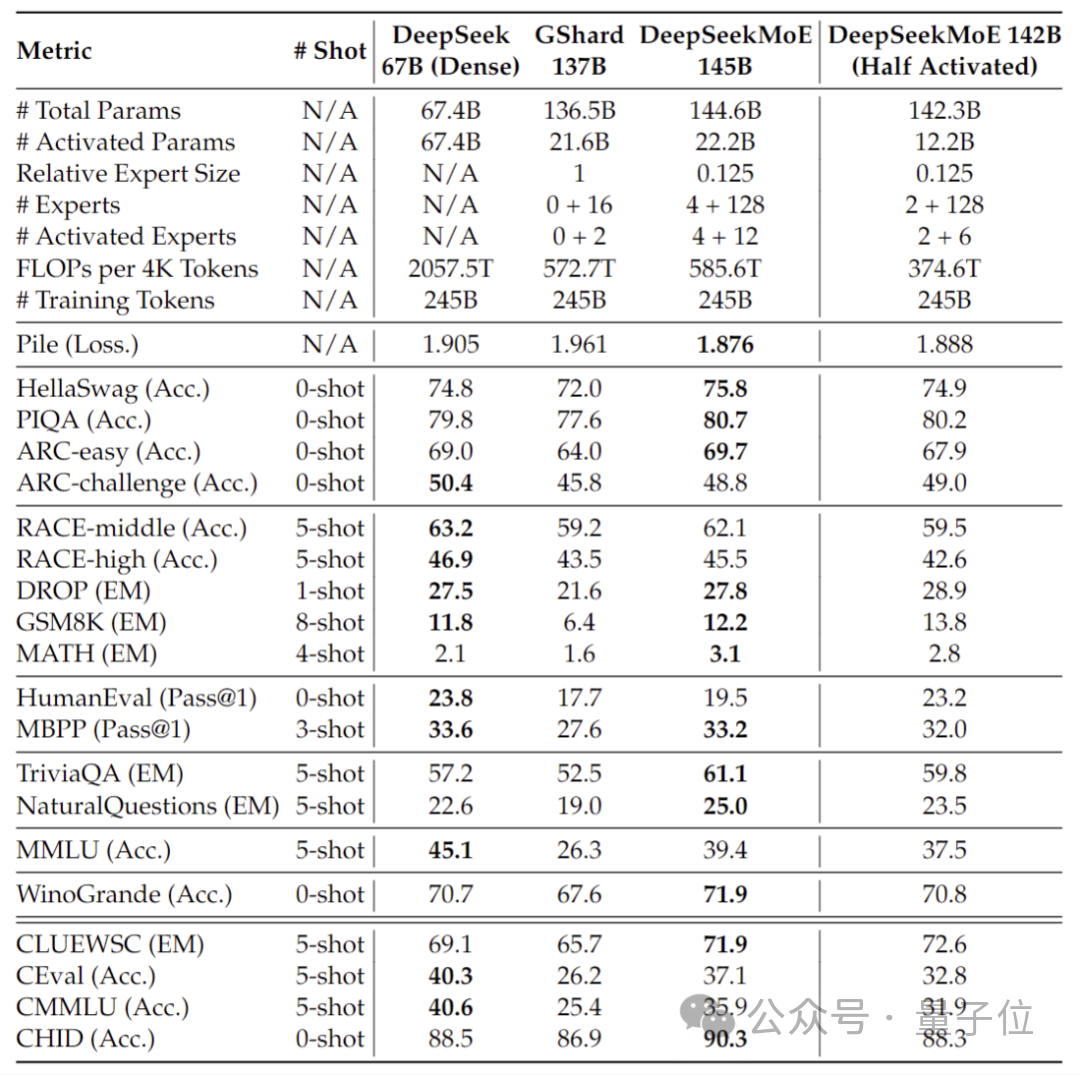

此外,深度求索团队还透露,DeepSeek MoE模型还有145B版本正在研发。

阶段性的初步试验显示,145B的DeepSeek MoE对GShard 137B具有极大的领先优势,同时能够以28.5%的计算量达到与密集版DeepSeek 67B模型相当的性能。

研发完毕后,团队也将对145B版本进行开源。

而在这些模型表现的背后,是DeepSeek全新的自研MoE架构。

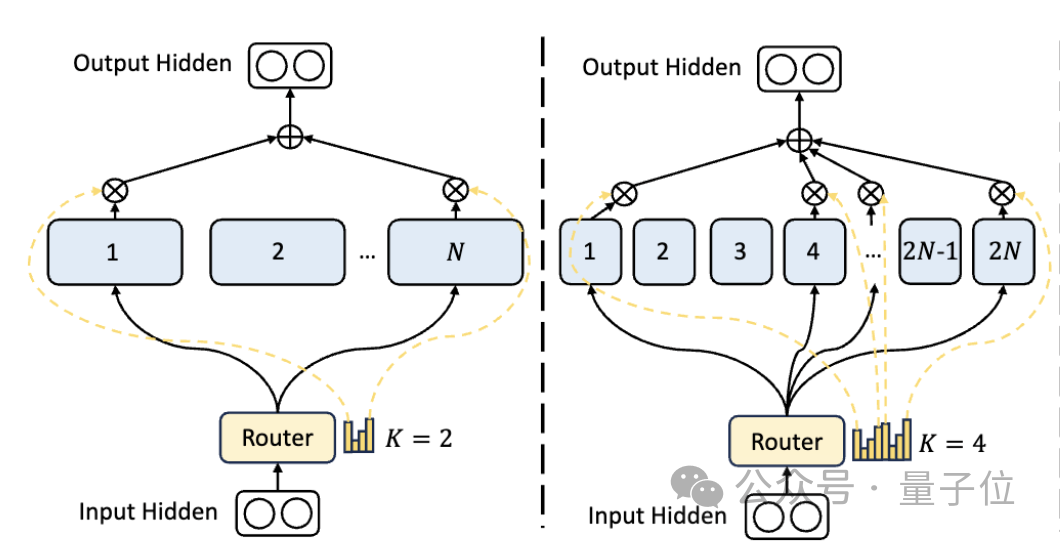

首先是相比于传统的MoE架构,DeepSeek拥有更细粒度专家划分。

在总参数量一定的情况下,传统模型分出N个专家,而DeepSeek可能分出2N个。

同时,每次执行任务时选择的专家数量也是传统模型的2倍,所以总体使用的参数量也不变,但选择的自由度增加了。

这种分割策略允许更灵活和适应性的激活专家组合,从而提高了模型在不同任务上的准确性和知识获取的针对性。

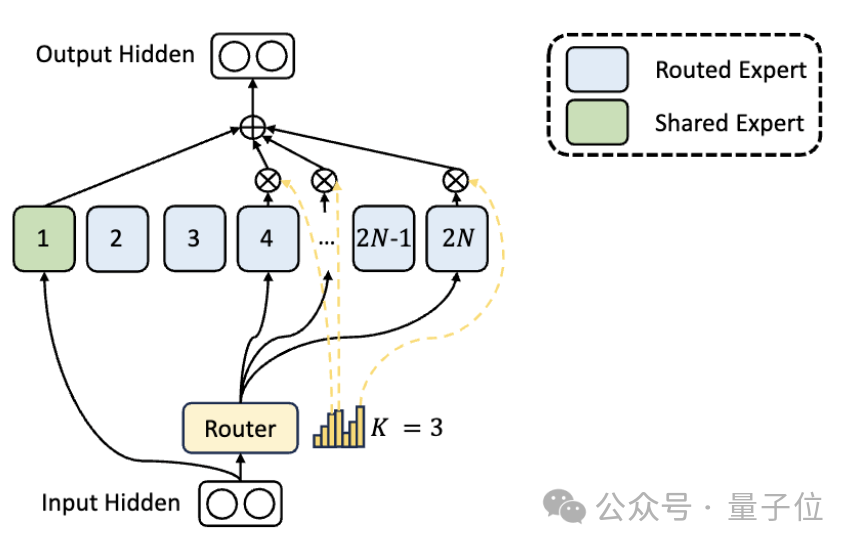

除了专家划分上的差异,DeepSeek还创新性地引入了“共享专家”的设置。

这些共享专家对所有输入的token激活,不受路由模块影响,目的是捕获和整合在不同上下文中都需要的共同知识。

通过将这些共享知识压缩到共享专家中,可以减少其他专家之间的参数冗余,从而提高模型的参数效率。

共享专家的设置有助于其他专家更加专注于其独特的知识领域,从而提高整体的专家专业化水平。

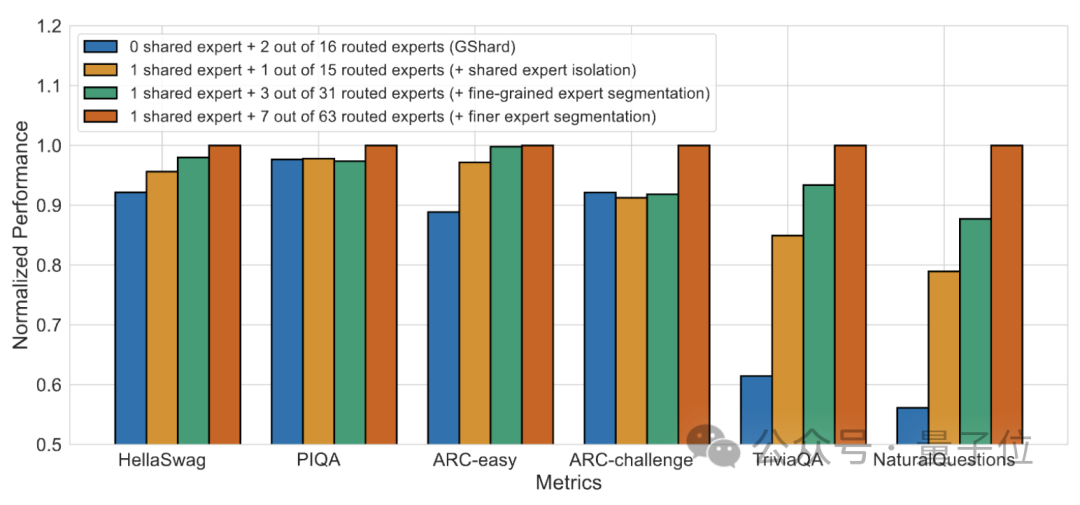

消融实验结果表明,这两个方案都为DeepSeek MoE的“降本增效”起到了重要作用。

论文地址:https://arxiv.org/abs/2401.06066。

参考链接:https://mp.weixin.qq.com/s/T9-EGxYuHcGQgXArLXGbgg。

以上就是引入国产开源MoE大模型,其性能媲美Llama 2-7B,同时计算量减少了60%的详细内容,更多请关注php中文网其它相关文章!

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号