我是fanstuck,专注于将前沿技术以通俗易懂的方式呈现给每一位读者,持续追踪ai领域的最新动态与发展趋势。如果你对大模型的创新实践、人工智能的技术演进及其真实场景落地感兴趣,欢迎持续关注我的分享。

当你只是调用现成模型、写写简单脚本或运行基础推理任务时,“算子”这个词可能显得遥远又枯燥。直到某一天,你上线的服务响应迟缓,某个OCR模块在GPU上卡顿严重,或者尝试在昇腾设备部署PyTorch模型时突然提示“缺算子”,导致整个流程直接中断——那一刻你才会意识到:算子,其实是AI系统的底层引擎,哪怕缺失一个,系统也可能瘫痪。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

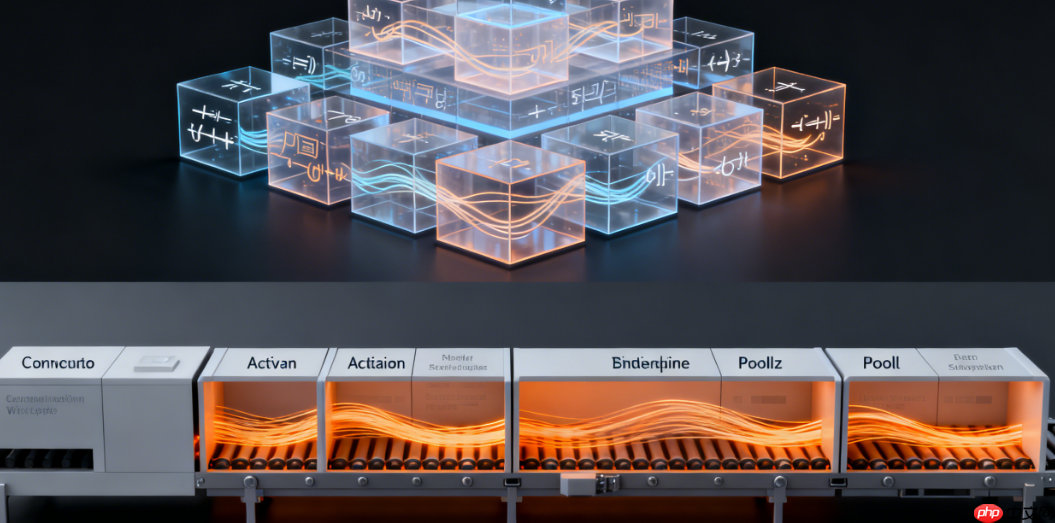

深度学习模型看似高深莫测,充斥着复杂的数学公式和网络结构,但从执行角度看,它更像一条精密的流水线,每个环节都由具体的算子驱动。你在Python中定义的模型不过是一份“设计图纸”,真正让模型运转起来的,是背后一个个高效执行的算子。它们决定了你的AI系统是疾驰如风,还是步履蹒跚。

深度学习模型看似高深莫测,充斥着复杂的数学公式和网络结构,但从执行角度看,它更像一条精密的流水线,每个环节都由具体的算子驱动。你在Python中定义的模型不过是一份“设计图纸”,真正让模型运转起来的,是背后一个个高效执行的算子。它们决定了你的AI系统是疾驰如风,还是步履蹒跚。

### 算子的核心价值

### 算子的核心价值

很多人第一次真正理解算子的重要性,往往是在实际部署过程中踩了坑。比如,你把一个基于Transformers架构的模型顺利跑在了GPU上,但迁移到昇腾平台时却报错:某个特定版本的LayerNorm或Softmax未被支持。这并非模型本身的问题,而是目标硬件平台上缺少对应的算子实现。就像你需要完成“翻炒”这个动作,但工厂里根本没有相应的机器,菜自然做不出来。

这种现象源于一个基本事实:硬件只认指令,不懂高级语言。

你写下 y = torch.relu(x),硬件无法理解;

你说“我要一个Attention层”,硬件更是无从下手。

硬件唯一能识别的是:

而算子的作用,正是把这些高层语义翻译成硬件可执行的“操作指令”。

你要做矩阵乘法?对应的是 MatMul 算子。

你想激活函数处理?那就是 ReLU 的任务。

你要计算注意力机制?背后需要 Softmax、BatchMatMul,甚至高度优化的 FlashAttention 实现。

因此可以总结为:

模型 = 多个算子的组合推理 = 算子序列的逐个执行性能 = 取决于算子的优化水平硬件差异 = 源于算子实现的不同跨平台迁移 = 关键在于是否有对应硬件的“算子版本”

算子是深度学习中最基本的“功能单元”。只要你涉及推理加速、训练效率提升、硬件适配、成本控制或性能调优——你就不可能绕开算子。

举个真实案例:某政企客户希望构建一套实时招标文件解析系统,初始GPU推理耗时约280ms,用户体验不够流畅。工程师的第一反应不是更换模型,而是深入分析算子瓶颈。发现卷积和 LayerNorm 是性能热点后,他们将标准卷积替换为 TensorRT 专用算子,并对 LayerNorm 和 Add 进行算子融合,减少一次内存访问。最终推理时间从280ms降至80ms。模型结构、参数、精度均未改变——仅仅是算子层面的优化,就让系统实现了质的飞跃。

这正是算子的魅力所在:它低调隐形,却直接决定模型能否高效落地。

这正是算子的魅力所在:它低调隐形,却直接决定模型能否高效落地。

进入大模型时代后,随着参数规模飙升、计算需求激增,同时用户对响应延迟愈发敏感,算子已成为性能优化的“关键命脉”。过去我们更关注模型结构创新,而现在真正的突破点越来越多来自算子层级的革新:三年来最火的 FlashAttention、KV Cache 技术、TensorRT-LLM、大规模融合算子等,无一不是算子级的工程突破,而非全新的算法理论。

甚至可以说:

如果把大模型比作一台高性能发动机,

那么每一个算子就是其中的一个活塞。

活塞效率低、响应慢、容易卡顿,再炫酷的外壳也无法让车跑起来。

所以,理解算子,就是理解模型为何能运行、如何提速、为何不同硬件表现迥异,以及为何所有大模型推理优化最终都会回归到算子这一层。

以上就是大模型时代的“积木”:算子到底解决了什么问题?的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号