在现代web应用中,高效的消息传递是非常重要的一环。消息队列是一种在不同系统之间异步传递消息的解决方案,可以优化数据传递和处理效率。在go语言中,beego框架是非常流行的web框架,支持开发web应用和api。在本文中,我们将探讨如何在beego中使用kafka实现消息队列,以实现高效的消息传递。

一、Kafka简介

kafka是一个分布式的、分区的、多副本的消息队列系统,最初由LinkedIn公司开发,后来由Apache软件基金会维护。kafka主要用于处理大量的实时数据,支持高吞吐量的消息传送,也支持跨多个消费者和生产者的多种应用程序。

kafka的核心概念是话题(topics)、分区(partitions)和偏移量(offsets)。话题指的是消息的分类,每个消息都属于一个特定的话题。分区则是话题的子集,每个分区都是一个有序的、不可变的消息队列。每个分区都可以在多个服务器上进行复制,以支持多个消费者同时处理同一分区。偏移量是唯一标识每条消息的值。消费者可以指定从特定的偏移量开始读取消息。

二、Beego中使用Kafka

安装kafka非常简单,只需要从kafka的官方网站下载压缩包,并解压到指定的目录即可。示例中使用的是kafka_2.12-2.3.0版本。

在开始使用kafka之前,需要创建一个新的话题和分区。可以使用Kafka自带的管理工具(kafka-topics.sh)来创建话题和分区。在命令行中执行以下命令:

bin/kafka-topics.sh --create --zookeeper localhost:2181 --replication-factor 1 --partitions 1 --topic test

这个命令会创建一个名为“test”的话题,只有一个分区,备份数量为1。可以根据自己的需求更改分区和备份数量。

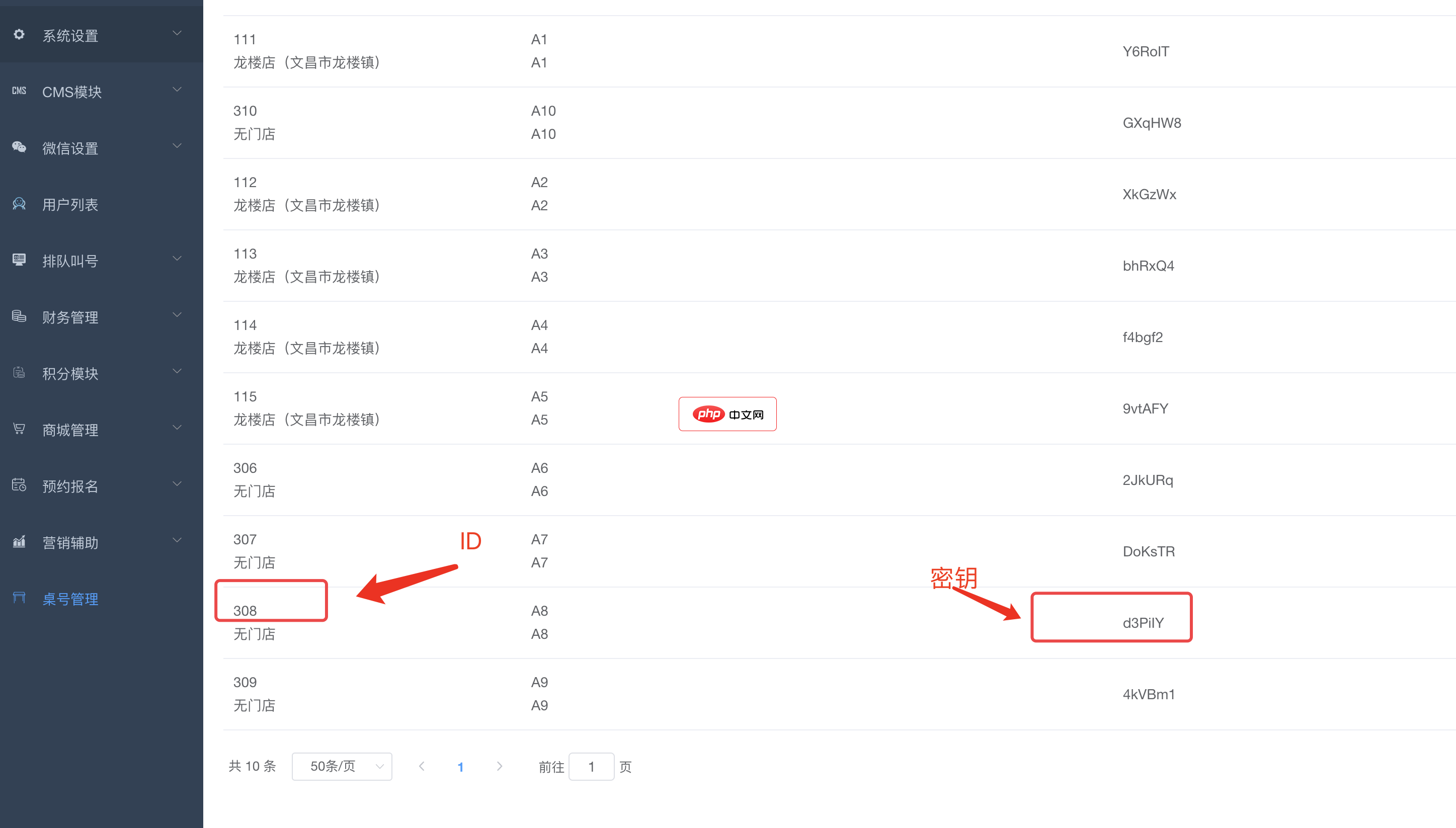

bee餐饮点餐外卖小程序是针对餐饮行业推出的一套完整的餐饮解决方案,实现了用户在线点餐下单、外卖、叫号排队、支付、配送等功能,完美的使餐饮行业更高效便捷!功能演示:1、桌号管理登录后台,左侧菜单 “桌号管理”,添加并管理你的桌号信息,添加以后在列表你将可以看到 ID 和 密钥,这两个数据用来生成桌子的二维码2、生成桌子二维码例如上面的ID为 308,密钥为 d3PiIY,那么现在去左侧菜单微信设置

1

1

创建kafka生产者的步骤如下:

package main

import (

"github.com/Shopify/sarama"

)

func main() {

// 设置kafka配置

config := sarama.NewConfig()

config.Producer.Return.Successes = true

// 新建生产者

producer, err := sarama.NewSyncProducer([]string{"localhost:9092"}, config)

if err != nil {

panic(err)

}

// 构造消息

message := &sarama.ProducerMessage{

Topic: "test",

Value: sarama.StringEncoder("test message"),

}

// 发送消息

_, _, err = producer.SendMessage(message)

if err != nil {

panic(err)

}

producer.Close()

}其中,sarama是Go语言客户端库,用于连接和操作kafka集群。以上代码中,我们创建了一个新的SyncProducer对象,然后发送了一条消息到“test”话题。

创建kafka消费者的步骤如下:

package main

import (

"fmt"

"github.com/Shopify/sarama"

"log"

"os"

"os/signal"

)

func main() {

config := sarama.NewConfig()

config.Consumer.Return.Errors = true

// 新建一个消费者

consumer, err := sarama.NewConsumer([]string{"localhost:9092"}, config)

if err != nil {

panic(err)

}

// 准备订阅话题

topic := "test"

partitionList, err := consumer.Partitions(topic)

if err != nil {

panic(err)

}

// 启动goroutine处理消息

for _, partition := range partitionList {

// 构造一个partitionConsumer

pc, err := consumer.ConsumePartition(topic, partition, sarama.OffsetNewest)

if err != nil {

panic(err)

}

go func(partitionConsumer sarama.PartitionConsumer) {

defer func() {

// 关闭consumer

if err := partitionConsumer.Close(); err != nil {

log.Fatalln(err)

}

}()

for msg := range partitionConsumer.Messages() {

fmt.Printf("Partition:%d Offset:%d Key:%s Value:%s

",

msg.Partition, msg.Offset, msg.Key, msg.Value)

}

}(pc)

}

// 处理中断信号

sigterm := make(chan os.Signal, 1)

signal.Notify(sigterm, os.Interrupt)

<-sigterm

fmt.Println("Shutdown")

consumer.Close()

}以上代码创建了一个新的消费者对象,并订阅了“test”话题。然后,启动了多个goroutine,以同时处理来自不同分区的消息。在消息处理后,调用了Close()方法以关闭消费者。

三、总结

在本文中,我们介绍了如何在Beego中使用kafka实现消息队列。这对于需要处理高吞吐量数据的Web应用程序非常有用。通过使用kafka,我们可以在多个消费者和生产者之间异步传递消息,以最大限度地提高数据传输和处理效率。如果你正在开发Beego应用程序,并需要高效的消息传递,那么kafka是一个非常优秀的选择。

以上就是在Beego中使用kafka实现消息队列的详细内容,更多请关注php中文网其它相关文章!

Kafka Eagle是一款结合了目前大数据Kafka监控工具的特点,重新研发的一块开源免费的Kafka集群优秀的监控工具。它可以非常方便的监控生产环境中的offset、lag变化、partition分布、owner等,有需要的小伙伴快来保存下载体验吧!

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号